Le Digital Single Lens Reflex (DSLR), note ai più come reflex digitali, sono delle semplici macchine fotografiche in cui la pellicola è stata sostituita da un sensore a semiconduttore. Mentre in passato era possibile ottenere il massimo da una fotografia agendo sul processo di sviluppo, oggi gioca un ruolo fondamentale il processo di acquisizione ed elaborazione delle immagini digitali. Inoltre a differenza delle macchine fotografiche analogiche dove la pellicola esposta alla luce diventava, una volta sviluppata, la vera e propria fotografia, nelle DSLR le informazioni accumulate nel sensore a semiconduttore vengono convertite in immagini che noi osserviamo sul monitor del nostro computer. Quindi nell’era digitale è importante conoscere a fondo il funzionamento del sensore e come, a partire da questo, viene costruita l’immagine finale. In particolare in questa sezione analizzeremo:

- Il sensore

- Dal fotoelemento al pixel

- La matrice di Bayer

- L’immagine digitale

- I file RAW, TIFF, JPEG e FITS

- Somma di immagini astronomiche:

- Light frame

- Segnale termico

- Bias frame

- Dark frame

- Flat frame

- Rumore e calibrazione del light frame

- Allineamento e combinazione delle immagini

- Elaborazione di immagini astronomiche:

- Livelli di luminosità e l’istogramma

- Correzione della gamma

- Calibrazione del colore

IL SENSORE

Lo sviluppo della fotografia digitale deve la sua origine all’invenzione dell’elemento fotosensibile a semiconduttore o photosite. Il funzionamento di questo componente elettronico è piuttosto semplice ragionando in termini di fotone. Un fotone possiamo immaginarlo come un singolo raggio di luce emesso dall’oggetto celeste che vogliamo riprendere. Una galassia, seppur debole, emette un numero incredibile di fotoni al secondo! Questi fotoni vengono focalizzati dallo schema ottico posto di fronte alla fotocamera digitale, sia esso un telescopio o un “semplice” obbiettivo, su un piano (focale) dove è situato l’elemento fotosensibile costituito da atomi di Silicio. I nuclei di questi ultimi, in condizioni normali, trattengono fortemente i propri elettroni che si dicono essere in banda di valenza. Quando arriva un fotone questo può urtare l’atomo di Silicio e strappargli un elettrone. Tale elettrone si dice essere così in banda di conduzione. A questo punto il fotoelemento è in grado di catturare questo elettrone “libero” ed accumularlo in una cella capacitiva. Il numero di elettroni nella cella genera così un segnale analogico (differenza di potenziale) proporzionale al numero di fotoni che hanno colpito il fotoelemento durante l’intera esposizione.

Ma che cos’è allora un sensore? Un sensore è semplicemente una griglia o matrice di elementi fotosensibili a semiconduttore e può essere di tipo CCD o CMOS. Nel primo caso (si parla di Charge-Coupled Device) il segnale analogico globale viene creato a partire da quello generato in ogni singolo fotoelemento. Questo successivamente viene amplificato, convertito in segnale digitale e mandato al computer della fotocamera.

Nel secondo caso (si parla di Complementary Metal Oxide Semiconductor) il segnale analogico di ogni cella viene amplificato uno per uno tramite piccoli amplificatori. Questo verrà poi trasformato in segnale digitale e mandato al computer.

Se anni fa vi era una differenza sostanziale tra CCD e CMOS, oggi i due tipi di sensori sono praticamente equivalenti sotto quasi tutti gli aspetti (rumore, risoluzione, …).

Ogni singolo fotoelemento a semiconduttore nelle DSLR è un quadrato con dimensione tipica pari a circa 5-8 μm e può accumulare sino a circa 40.000 elettroni. Nel caso particolare del sensore CMOS montato sulla DSLR Canon EOS 40D le dimensioni del fotoelemento sono pari a 5.7 μm. Il numero totale di fotoelementi presenti in un sensore determinano il numero di pixel della DSLR (vedremo che la parola pixel è, in questo caso, un abuso di notazione). Nel caso della Canon EOS 40D il sensore è costituito da 3.888 x 2.592 fotoelementi ovvero 10.077.696 pixel (10.1 Megapixel).

Un altro parametro importante per quanto riguarda i sensori è la discretizzazione. Con questo termine si vuole indicare il fatto che il numero di elettroni accumulati in un fotoelemento è necessariamente discreto. Questo spiega perché una fotocamera digitale non può distinguere tra un numero infinito di livelli di luminosità.

I livelli di luminosità vengono assegnati durante la fase di conversione del segnale analogico generato dai fotoelementi in segnale digitale. In particolare il numero di tali livelli dipendono dal numero di bit impiegati nella digitalizzazione del segnale. Nel caso della Canon EOS 40D la digitalizzazione avviene a 14 bit (processore DIGIC III) e quindi si hanno a disposizione 16.384 livelli dove al numero 0 è associato il nero e al numero 16.383 il bianco.

Come si può vedere il numero di livelli è inferiore al massimo numero di elettroni accumulabili in un fotoelemento con una perdita di segnale. Lo studio di processori che utilizzano un numero di bit sempre più grandi sono una richiesta fondamentale per lo sviluppo delle DSLR.

Prima di concludere questa digressione sui sensori è necessario ricordare che per le fotocamere digitali con ISO intendiamo il fattore di amplificazione del segnale durante il processo di digitalizzazione. Ovviamente il rumore, dettato dall’amplificatore, giocherà un ruolo importantissimo nell’aumento del numero di ISO. Per la Canon EOS 40D il massimo numero di ISO è fissato a 3.200.

DAL FOTOELEMENTO AL PIXEL

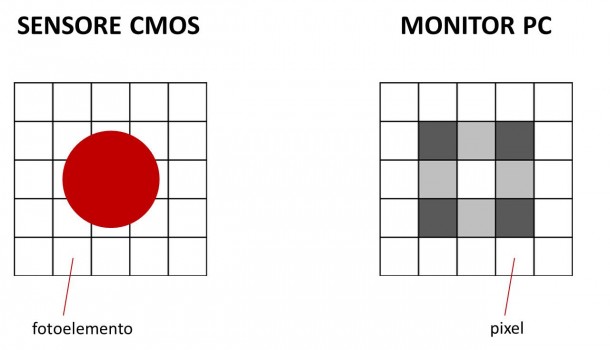

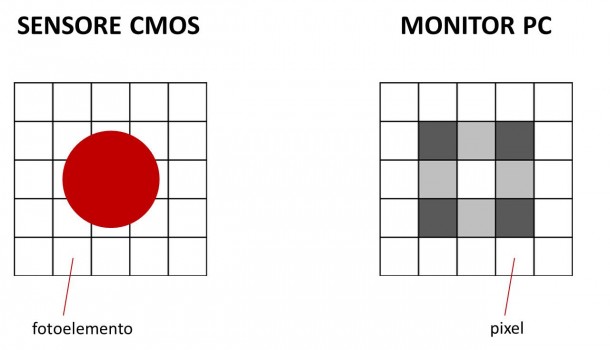

In questo paragrafo vedremo il passaggio dal concetto di fotoelemento a quello di pixel. Spesso i due termini vengono confusi malgrado abbiano significati completamente differenti. Come abbiamo visto, il fotoelemento è il componente elettronico elementare del sensore. I fotoni che colpiscono un fotoelemento generano un segnale proporzionale al loro numero. Questi segnali vengono poi discretizzati durante il processo di conversione analogico – digitale. Alla matrice fisica di fotoelementi del sensore è così associata una matrice numerica dove ogni elemento è detto pixel. A partire dalle informazioni contenute in ciascun pixel sarà poi possibile costruire l’immagine che vedremo visualizzata sullo schermo. In figura è rappresentata la relazione tra fotoelemento e pixel nel caso di illuminazione da parte di un disco stellare (cerchio rosso).

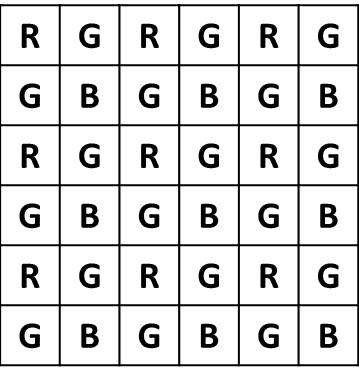

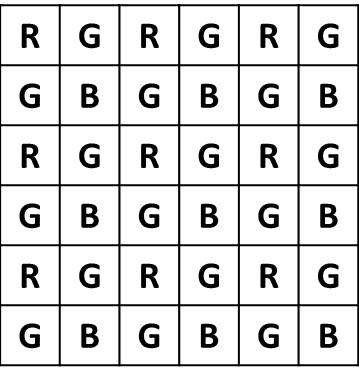

Quando parliamo di DSLR a colori cadiamo spesso in errore pensando che il sensore CMOS o CCD sia realmente sensibile al colore. In realtà il sensore, così come i fotoelementi sono in bianco e nero. Allora come è possibile che le immagini riprese con la nostra macchina fotografica digitale appaiano a colori? Il segreto sta nell’interposizione di quattro filtri colorati di fronte ad ogni fotoelemento. La configurazione più comune è la RGBG o comunemente RGB in cui i quattro filtri sono due verdi, uno rosso ed uno blu. In questo modo, nel caso della Canon EOS 40D dei 10 milioni di fotoelementi del sensore, circa 2.5 milioni sono sensibili al rosso, 2.5 milioni al blu e 5.0 milioni al verde. Il fatto che i fotoelementi sensibili al verde siano in sovrannumero è dovuto alla maggior sensibilità dell’occhio umano a queste frequenze.

A partire dai segnali nei canali rosso, verde e blu è possibile tramite un’opportuna combinazione estrarre informazioni sulla luminosità e colore dell’oggetto. Questo metodo venne inventato da B. Bayer per la Kodak nel 1975 ed ancor oggi è utilizzato nella maggior parte delle DSLR. La matrice di pixel RGBG disposti come in figura prende il nome di “matrice di Bayer”.

Molteplici sono i metodi che permettono di estrarre informazioni sul colore e luminosità dell’immagine a partire dalla matrice di Bayer. Tra i più noti ricordiamo il metodo dell’interpolazione e del super-pixel. Nel caso invece della somma di più immagini a colori è possibile utilizzare anche il metodo Bayer drizzle. Per maggiori informazioni su questi metodi di combinazione si legga la guida tecnica di DeepSkyStacker.

Molteplici sono i metodi che permettono di estrarre informazioni sul colore e luminosità dell’immagine a partire dalla matrice di Bayer. Tra i più noti ricordiamo il metodo dell’interpolazione e del super-pixel. Nel caso invece della somma di più immagini a colori è possibile utilizzare anche il metodo Bayer drizzle. Per maggiori informazioni su questi metodi di combinazione si legga la guida tecnica di DeepSkyStacker.

L’IMMAGINE DIGITALE

Dopo aver distinto tra fotoelemento e pixel è possibile definire l’immagine digitale come una matrice di numeri che rappresentano, per ogni canale (ad esempio rosso, verde e blu), i livelli di luminosità. Tali numeri sono definiti pixel.

I livelli di luminosità abbiamo visto dipendere dal numero di bit utilizzati nel processo di digitalizzazione del segnale analogico generato dal sensore. Per quanto riguarda la Canon EOS 40D, per ogni canale, i livelli di luminosità sono 16.384 (14 bit). L’occhio umano non sa però distinguere più di 256 livelli di luminosità e quindi immagini a 8 bit possono ritenersi più che buone. Questo non è però vero per quanto riguarda la somma di immagini dove la qualità del risultato aumenta all’aumentare del numero di livelli di luminosità delle singole immagini.

Concludendo, un’immagine digitale è quindi costituita, per ciascun canale (RGB), da una matrice di pixel. Ciascun pixel è rappresentato a sua volta da un numero compreso tra 0 e NNbit-1, dove Nbit è il numero di bit che rappresenta il suo livello di luminosità. Al fine di non perdere queste preziose informazioni è necessario memorizzare la nostra immagine digitale in un file.

I FILE RAW, TIFF, JPEG e FITS

File RAW (CR2)

Il formato RAW significa appunto immagine “grezza”, non processata. Questa immagine non è visualizzabile a video direttamente ma contiene tutte le informazioni così come generate dal sensore CCD o CMOS. In particolare nella maggior parte delle DSLR le informazioni sono memorizzate basandosi su uno schema a matrice di Bayer la quale può essere successivamente processata secondo uno degli schemi precedentemente accennati. Questo è il formato ideale per la somma di immagini astronomiche e non solo, dato che nei file RAW sono contenute tutte le informazioni che possono essere estratte dalla nostra DSLR. Nel caso della Canon EOS 40D le immagini in formato CRW (estensione *.CR2) sono, per quanto detto precedentemente, immagini a 14 bit. I file RAW contengono inoltre informazioni sulla posa che vengono opportunamente scritte nell’header del file.

File TIFF

Il formato TIFF (Tagged Image File Format) è il migliore dopo il RAW. Di file TIFF ne esistono una grande varietà: a 8 bit, a 16 bit, in scala di grigio, RGB o CMYK, non compressi, compressi LZW o RLE, su piani multipli o no (immagini su più pagine). Dato che la compressione LZW è proprietaria dal 2006, molti software gratuiti o a basso prezzo non la supportano.

File JPEG

Questo è il formato più utilizzato dalle DSLR, automaticamente elaborato dalla fotocamera. Il file JPEG è compresso e se da un lato occupa meno spazio su disco, dall’altro abbiamo una perdita di dettagli a basso contrasto. Il grado di compressione è regolabile e un file JPEG compresso al minimo è confrontabile in termini di qualità con un file TIFF. File JPEG in colore RGB è lo standard utilizzato per la pubblicazione di fotografie su internet.

File FITS

Questo è il formato più utilizzato per le immagini astronomiche. Sfortunatamente fuori da questo contesto i file FITS sono poco utilizzati e spesso non sono supportati da software non propriamente astronomico. I file FITS sono i più adattabili e possono essere utilizzati a 8 bit, 16 bit, 32 bit e 64 bit con o senza compressione. Questo formato contiene un header in cui sono memorizzate informazioni sulla ripresa e possono essere lette con un comune editor di testo.

LIGHT FRAME

Consideriamo un esempio pratico in cui noi riprendiamo con il nostro telescopio o obbiettivo fotografico una galassia. I fotoni emessi dalla galassia interagiranno con gli atomi di Silicio dei 10 milioni di fotoelementi del sensore e verranno convertiti in elettroni che costituiranno il nostro segnale analogico. Questo sarà proporzionale al numero di fotoni che avranno interagito con ciascun fotoelemento durante l’intero tempo di esposizione. Successivamente il segnale analogico (uno per canale) viene convertito in un segnale digitale da cui il concetto di pixel. Il risultato complessivo è la matrice di Bayer RGB in cui in ogni pixel è riportato un valore numerico che rappresenta il livello di luminosità compreso tra 0 (nero) e 2Nbit-1 (bianco) dove Nbit è il numero di bit utilizzato per la codifica analogico – digitale. Nel caso della Canon EOS 40D Nbit = 14. A questo punto i dati relativi alla ripresa (tipo di fotocamera, tempo di esposizione, diaframma, ISO …) insieme alla matrice di Bayer per i canali RGB vengono memorizzati in un file RAW.

Alla fine della nostra ripresa fotografica avremo quindi un file RAW che, anche se non è ancora un’immagine digitale vera e propria, contiene tutte le informazioni necessarie per crearla.

Con un abuso di notazione chiameremo con la parola “immagini” tali file RAW. Definiamo perciò light frame l’immagine della galassia ripresa. Questo light frame è importantissimo e rappresenta l’immagine originale, senza modifiche, elaborazione o compressioni ed è perciò importante crearne una copia di backup.

Il light frame non contiene però solo il segnale della galassia, ovvero l’immagine della galassia vera, così come la vedono i nostri occhi (o anche meglio), ma altri tipi di segnali indesiderati a ciascuno dei quali è associato un certo livello di rumore. Tra i segnali indesiderati ricordiamo i più importanti:

- Segnale di BIAS e segnale termico,

- Non uniformità del campo di ripresa, vignettatura, polvere, differente sensibilità di ciascun fotoelemento, …

Analizziamo ora uno ad uno questi segnali.

SEGNALE TERMICO

Il primo dei segnali indesiderati presenti nel light frame è il segnale termico o corrente di buio. Per capire questo segnale bisogna fare un passo indietro e considerare di nuovo il funzionamento del fotoelemento a semiconduttore. Abbiamo visto come il segnale generato dal singolo fotoelemento sia dovuto all’accumulo di elettroni “strappati” ai nuclei di Silicio a seguito dell’urto di un fotone. Naturale pensare quindi che se non ci sono fotoni (ovvero il fotoelemento è al buio) i nuclei di Silicio trattengono i loro elettroni e quindi non abbiamo segnale. Ebbene non è esattamente così. L’agitazione termica può infatti indurre alcuni elettroni a passare dalla banda di valenza a quella di conduzione e quindi generare un segnale spurio. Tale segnale è appunto il segnale termico.

BIAS FRAME

Un altro segnale indesiderato presente nel light frame è il segnale elettronico o di lettura. Immaginiamo ora che i fotoelementi a semiconduttore si comportino in maniera ideale. Se questi non vengono illuminati allora non ci sono fotoni e quindi elettroni liberi. Questa condizione genererebbe un segnale analogico nullo. Tale segnale poi sarà processato da una catena elettronica (dal fotoelemento al sensore, convertitore analogico – digitale, …). Dato che questa non è ideale ma costituita da componenti reali, il segnale finale non sarà una matrice di pixel con livello di luminosità 0 ma quello che prende il nome di BIAS frame.

Il BIAS frame non è quindi legato al processo di fotorivelazione ma unicamente all’elettronica della nostra SLDR. Il light frame conterrà quindi, oltre al segnale della galassia anche il segnale elettronico che dovrà essere quindi sottratto. Come fare ciò?

Quello che si deve realizzare è un BIAS frame ovvero la risposta dell’elettronica all’assenza di segnale da parte del sensore. Come detto precedentemente avremmo bisogno di un sensore ideale che riprenda un’immagine di buio assoluto. Sensore ideale significa privo di segnale termico. Per fare questo dovremmo concettualmente esporre con tempo di esposizione nullo. Questo non è possibile. Quello che possiamo fare è quindi esporre con il tempo più veloce possibile. Nel caso della Canon EOS 40D tale tempo di esposizione è 1/8000 di secondo. Ovviamente l’esposizione deve avvenire al buio e questo può essere ottenuto tappando il nostro sistema ottico (telescopio o obbiettivo). Ecco quindi che oltre al light frame, memorizzato in un file RAW, abbiamo anche il BIAS frame, sempre memorizzato in un file RAW.

DARK FRAME

Definito il BIAS frame, come ricostruire un’immagine del segnale termico (detto thermal frame) associato al nostro light frame? La risposta è con il dark frame. Il Dark frame è un’immagine con tempo di esposizione uguale a quello del light frame ma ripresa in condizioni di buio. Tale immagine è però soggetta come il light frame al segnale elettronico. Il thermal frame sarà quindi dato dalla sottrazione del BIAS frame dal dark frame. Per realizzare il dark frame basta quindi tappare il nostro sistema ottico (telescopio o obbiettivo) e riprendere un’immagine (altro file RAW) con lo stesso tempo di esposizione del light frame.

FLAT FRAME

A questo punto non ci rimane che studiare l’ultimo tipo di segnale ovvero quello che dipende dalle non uniformità della ripresa come campo distorto, vignettatura, povere, non idealità dei fotoelementi, …

Per fare questo è necessario riprendere una superficie uniformemente illuminata senza modificare l’ottica e la posizione della fotocamera digitale. Se il nostro sensore fosse ideale allora ogni fotoelemento è irraggiato dallo stesso numero di fotoni e quindi medesima altezza del segnale prodotto. Questo non avviene poiché ogni fotoelemento ha una differente sensibilità. Inoltre dei granelli di polvere depositati sul filtro IR posto di fronte al sensore potrebbero parzialmente oscurare alcuni fotoelementi. Infine ricordiamo che anche l’ottica utilizzata (obbiettivo o telescopio) potrebbero trasformare una sorgente uniforme di luce in una non uniforme sul sensore a causa di difetti ottici come la vignettatura. Riprendendo quindi l’immagine di una sorgente uniformemente illuminata è possibile estrarre informazioni su tutti questi tipi di “difetti”. Tale immagine prende il nome di flat frame. Per realizzare il flat frame è quindi necessario riprendere una superficie uniformemente illuminata (con una flat box per esempio) senza modificare l’ottica e la posizione della fotocamera digitale. Il tempo di esposizione deve essere scelto in modo che il livello di luminosità medio sia circa il 50% di quello di saturazione. Per fare questo è consigliabile farsi aiutare dall’istogramma (vedi il post sull’elaborazione di immagini astronomiche). Gli ISO ed il diaframma dovranno essere impostati con lo stesso valore del light frame. Ovviamente anche il flat frame sarà soggetto al segnale di BIAS e termico che dovranno essere sottratti. Se le condizioni di ripresa del BIAS frame per il light frame sono le stesse in cui è stato ripreso il flat frame (condizioni ambientali invariate) allora non è necessario riprendere un altro BIAS frame. Dato che invece il tempo di esposizione del flat frame è generalmente diverso da quello del light frame sarà necessario riprendere anche il dark frame relativo al flat frame.

RUMORE E CALIBRAZIONE DEL LIGHT FRAME

Si è discusso di segnali spuri di tipo termico, elettronico o di flat. Abbiamo sempre utilizzato la parola segnale al fine di indicare la riproducibilità degli stessi. Infatti un dark frame, un BIAS frame o un flat frame effettuati nelle stesse condizioni riproducono “quasi” lo stesso tipo di immagine. Il quasi sta ad indicare che ogni ripresa e sempre diversa da un’altra in quanto soggetta a rumore. Nella parola “rumore” riassumiamo una serie di fenomeni che non permettono la perfetta riproducibilità di un’immagine pur operando nelle stesse identiche condizioni. Quindi se illuminiamo uniformemente un fotoelemento con una sorgente di luce, alla valle della catena di acquisizione vedremo un livello di luminosità che varia nel tempo in modo sostanzialmente casuale. Ora supponiamo di avere un fotoelemento che riceve per ogni esposizione 100 fotoni. Supponendo di trascurare i segnali spuri, il solo rumore farà si che alla fine il livello di luminosità del pixel sia 100, 101, 99, 100, 101, 99, 99, 101, 100, … variando di esposizione in esposizione malgrado le condizioni di posa siano rimaste inalterate. Se ora però supponiamo di effettuare 9 pose identiche ed effettuiamo, per il fotoelemento considerato, la media del livello di luminosità del pixel allora (100 + 101 + 99 + 100 + 101 + 99 + 99 + 101 + 100)/9 = 100. Questo significa che se il singolo scatto può fluttuare tra 99 a 101 in modo casuale, la media fornisce un valore più simile a quello vero. Quanto simile? Dipende dall’operazione che si effettua sul pixel. Per la maggior parte dei metodi (media, mediana, kappa – sigma clipping, media pesata auto adattiva, …) il rapporto segnale rumore aumenta con la radice quadrata del numero di scatti (frame). Se in una posa una stella ha un livello di luminosità 100 con rumore 1 il relativo rapporto segnale rumore è S/N = 100/1 = 100 (S/N è il simbolo del rapporto segnale rumore dove N sta per noise ovvero rumore in inglese). Se ora facciamo 10 riprese “identiche” della stessa stella allora il rapporto segnale rumore diviene S/N = 100 √10 = 316. Cosa significa questo? Che se prima avevo una fluttuazione sull’immagine pari all’1.0% mediando 10 frame avrò una fluttuazione sull’immagine pari al 0.3%.

La riduzione del rumore o meglio l’aumento del rapporto segnale rumore significa un aumento dei dettagli dell’immagine. Maggiori quindi saranno il numero di frame e maggiore sarà la qualità dell’immagine finale.

Questo può (deve) essere fatto con tutti i frame precedentemente analizzati: light frame, dark frame, bias frame, flat frame, dark flat frame e bias flat frame. Il procedimento più corretto è ridurre il rumore di tutti i frame contenenti segnali spuri. Tali frame si chiameranno master. Quindi il primo passo per la combinazione delle immagini digitali è creare i master dark frame, master bias frame, master flat frame, master dark flat frame e se necessario il master bias flat frame.

A questo punto si procede con il processo di calibrazione del light frame, ovvero per ogni light frame si effettua la seguente operazione pixel a pixel:

light frame calibrato = [(light frame-master bias frame)-(master dark frame-master bias frame)] : [(master flat frame-master bias flat frame)-(master dark flat frame-master bias flat frame)]

Alla fine di questo procedimento avremo tanti light frame calibrati ovvero light frame a cui sono stati sottratti i segnali spuri.

ALLINEAMENTO E COMBINAZIONE DELLE IMMAGINI

Una volta ottenuto il nostro insieme di light frame calibrati, non ci resta che ridurne il rumore operando su di essi come abbiamo fatto per i dark, flat, … . Quindi pixel per pixel è possibile effettuare la media, la mediana, … dei livelli di luminosità ottenendo il master light frame calibrato. Dato però che l’inseguimento effettuato da una qualsiasi montatura astronomica non è mai perfetto, è necessario allineare le immagini prima di combinarle. Infine è possibile anche sottrarre ai singoli light frame calibrati i pixel caldi e freddi ovvero i fotoelementi a semiconduttori del sensore non funzionanti e che quindi generano sempre un segnale identico e ovviamente sbagliato. Tutte queste funzioni oltre a quelle di costruzione dei master frame dei segnali spuri vengono effettuati da molti software dedicati, tra cui ricordiamo il gratuito DeepSkyStacker (ricordiamo che stacker in inglese significa combinazione di immagini) o IRIS. Per maggiori dettagli sul funzionamento dei suddetti programmi vi invitiamo a leggere i manuali utente disponibili agli indirizzi http://deepskystacker.free.fr/english/index.html e http://www.astrosurf.com/buil/us/iris/iris.htm .

LIVELLI DI LUMINOSITÀ E ISTOGRAMMA

Abbiamo visto come il processo di digitalizzazione del segnale prodotto dal sensore produce una matrice di pixel in cui il numero di elettroni raccolto in ogni fotoelemento viene tradotto in un numero compreso tra 0 e 2Nbit-1, dove Nbit è il numero di bit con cui viene digitalizzato il segnale. Tale numero viene spesso indicato come livello di luminosità e l’unità di misura è detta ADU (Analog to Digital Unit). L’occhio umano non può però distinguere più di 256 livelli (ovvero i nostri occhi sono a 8 bit) e per questo, qualsiasi sia il numero di bit dell’immagine RAW, alla fine del nostro processo di elaborazione dovremo convertire l’immagine in una a 8 bit. Per lo stesso motivo alcuni programmi di elaborazione come Photoshop presentano sempre scale di livelli di luminosità a 8 bit anche se l’immagine è stata digitalizzata a valori di bit superiori. Come facilmente intuibile 0 ADU rappresenta il colore nero e 255 ADU il colore bianco. Tra 0 e 255 si trova tutta la varietà di grigi (ricordiamo che le immagini prodotte dalla DSLR sono in bianco e nero).

Quando riprendiamo un’immagine digitale quindi, ogni pixel avrà per ogni canale (ad esempio RGB) un livello di luminosità misurato in ADU. Se ora rappresentiamo in un grafico la distribuzione dei pixel per un dato valore di luminosità otteniamo quello che comunemente prende il nome di istogramma.

Per quanto riguarda la fotografia astronomica l’istogramma può assumere diverse forme a seconda del soggetto ripreso. Se siamo di fronte ad un oggetto diffuso come una nebulosa allora l’istogramma avrà un picco per bassi valori di ADU associato al fondo cielo ed una lunga coda che si prolungherà fino al valore di 256 ADU che rappresenta le stelle e le parti più luminose (bianche) della nebulosa. Nella coda troviamo tutta la varietà di grigi associata alle varie sfumature della nebulosa.

Nel caso invece di riprese planetarie allora avremo nuovamente un picco nella zona a bassi ADU associato al fondo cielo ma invece della coda avremo una distribuzione complessa che dipenderà dalla colorazione della superficie (o atmosfera) del pianeta.

Anche se in modo diverso dalla fotografia diurna l’istogramma può darci informazioni riguardo alla corretta esposizione della nostra immagine. Immagini sottoesposte avranno un istogramma sostanzialmente concentrato intorno ad un valore basso di ADU, mentre immagini sovraesposte avranno lo stesso picco ma intorno a valori alti di ADU. Ovvio che molto dipende anche dal soggetto che stiamo riprendendo. Ma cosa succede se l’immagine non ha tutte le varietà di grigio? L’istogramma sarà allora diverso da zero solo in una zona limitata di ADU. In questo caso è possibile elaborare l’immagine in modo da estendere questa zona a tutti i possibili valori di ADU. Tale processo prende il nome di equalizzazione dell’istogramma.

CORREZIONE DELLA GAMMA

Abbiamo visto nei precedenti capitoli come l’immagine RAW sia una “traduzione” in pixel della carica elettrica accumulata nei singoli fotoelementi. Tale carica è proporzionale (o in relazione lineare) al numero di fotoni e quindi alla luminosità dell’oggetto ripreso. L’occhio umano a sua volta trasformerà i fotoni prodotti dai singoli pixel in segnale in grado di generare l’immagine nel nostro cervello. Questa seconda trasformazione è però non lineare, dato che l’occhio è più sensibile ai mezzi toni ed alle differenze chiaro – scuro. Matematicamente questo si traduce in una risposta logaritmica dei nostri occhi alla luce. In generale è quindi necessario tarare lo strumento con cui osserviamo l’immagine digitale in modo che la sua risposta alla luminosità fornita dal sensore sia il più possibile simile a quella dell’occhio umano. Questo per evitare che l’occhio umano percepisca come sottoesposta un’immagine ricca di mezzi toni scuri. In generale possiamo definire:

luminosità percepita (come frazione del massimo) = (valore luminosità del pixel : massimo valore di luminosità del pixel)γ

dove γ≈ 2.2. Il parametro gamma ci dice quanto la luminosità percepita differisca dalla vera rispetto ad una relazione di tipo lineare data da γ = 1. Lo schermo dei nostri LCD, monitor, stampanti a colori o fotografiche devono simulare il più possibile la luminosità percepita dal nostro occhio. In questo modo, per non perdere informazioni, è necessario correggere l’immagine digitale in modo da rimettere in relazione lineare il numero di fotoni dell’oggetto e la luminosità dello stesso cosi come si raffigura nel nostro cervello. Tale correzione può essere realizzata attraverso la formula:

pixel corretti = massimo valore dei pixel corretti (pixel non corretti : massimo valore dei pixel non corretti)1/γ

Questa correzione è necessaria per rendere correttamente visibile l’immagine all’occhio umano e normalmente viene effettuata dai software di elaborazione di immagini astronomiche o dalla DSLR nel caso scattassimo le nostre fotografie in formato JPEG.

CALIBRAZIONE DEL COLORE

Una volta elaborata la nostra immagine astronomica digitale, otteniamo un’immagine a colori corretta in tutti i canali (per esempio RGB). A questo punto non è detto che i colori della nostra immagini siano esattamente quelli reali o in ogni caso l’immagine potrebbe avere una dominante. Per risolvere questo problema alcuni programmi di elaborazione come Photoshop ma anche lo stesso IRIS permette di pesare (regolare) i tre canali in modo differente, correggendo così l’eventuale colore dominante. Nel caso della Canon EOS 40D i pesi dei tre canali sono generalmente: Rosso 1.96, Verde 1.00, Blu 1.23.

Questi dovrebbero fornire un’immagine con colori in buona approssimazione simili a quelli reali. Se invece si vuole effettuare delle misure fotometriche (ovvero avere un’immagine con i colori reali) allora la calibrazione del colore può divenire più complicata.

Una volta calibrato il colore è possibile, sempre con i software per l’elaborazione delle immagini digitali, agire sulla luminosità e il contrasto dell’immagine, le curve, oppure sulla correzione dei colori per i chiari, i scuri o i mezzi toni in modo da dare all’immagine l’aspetto che preferiamo. Questi metodi insieme all’applicazione di maschere, deconvoluzione dell’immagine, riduzione dell’inquinamento luminoso, eccetera saranno trattati in futuri post.