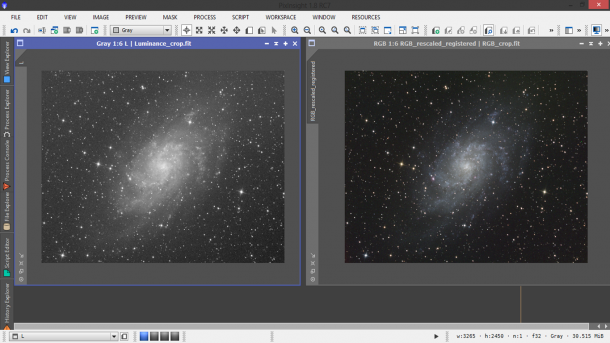

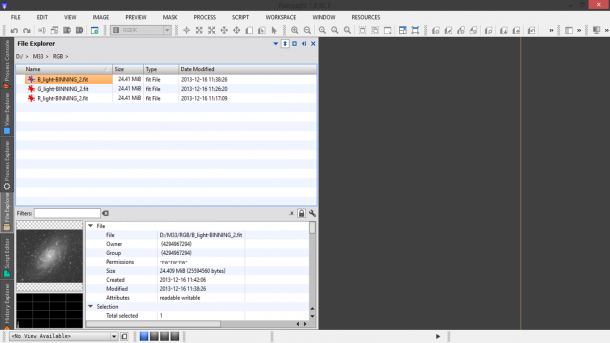

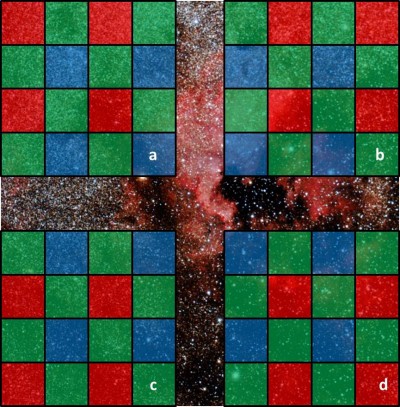

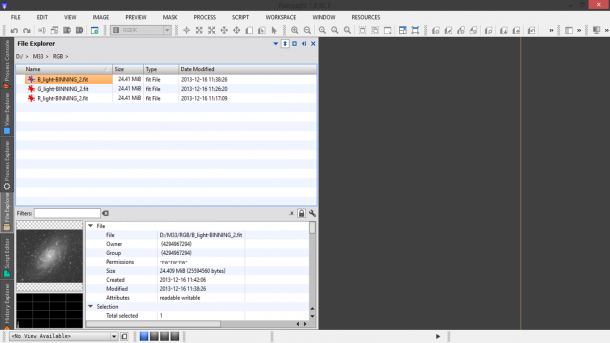

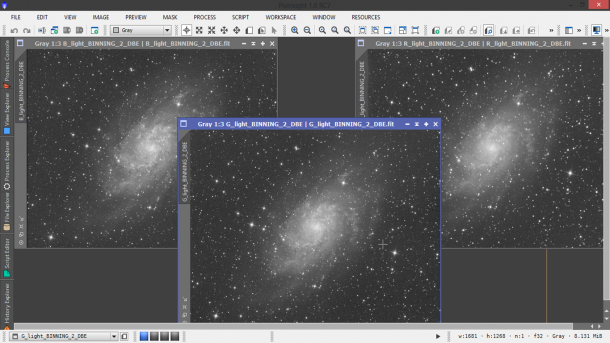

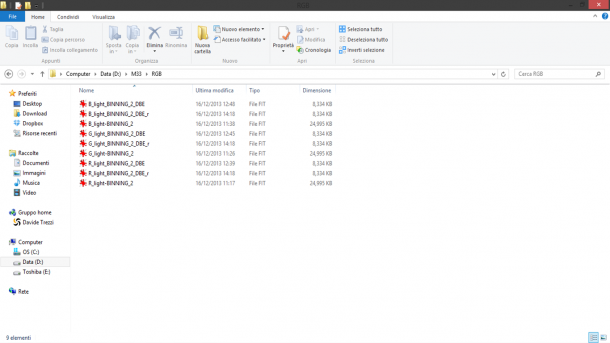

Nel post “Calibrazione delle immagini astronomiche“ abbiamo imparato ad ottenere il master light a partire dai nostri bias, dark e flat field frame. In questo post vedremo come utilizzare le immagini così calibrate per i canali R, G e B al fine di ottenere l’immagine a colori (RGB). Partiamo quindi creando una cartella RGB dove metteremo i master light dei tre canali realizzati con PixInsight. Questi sono visualizzabili attraverso l’utility File Explorer, disponibile nei tab a destra (Figura 1). Le tre immagini, prese singolarmente, sono ben calibrate ma confrontate mostrano gradienti differenti. Al fine di ridurre questi gradienti possiamo utilizzare l’importante tool di PixInsight noto come DynamicBackgroundExtractor o per gli amici DBE.

Figura 1: i canali R,G e B calibrati con PixInsight.

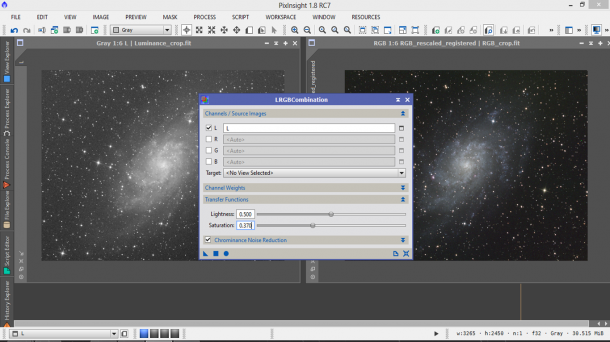

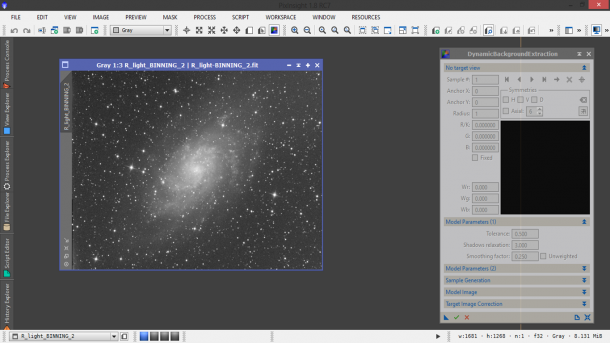

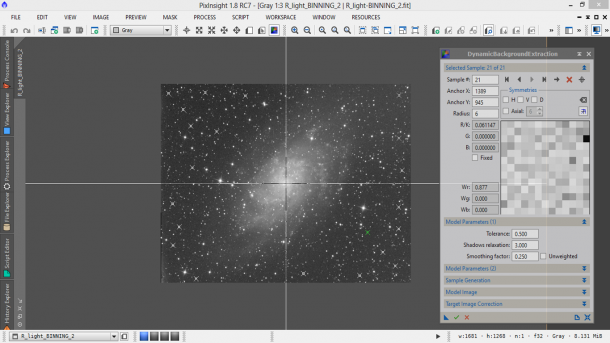

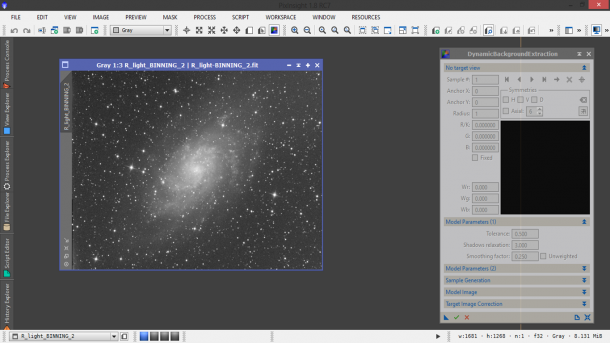

Apriamo DBE cliccando su Process → BackgroundModelization → DynamicBackgroundExtraction oppure utilizzando il Process Explorer. Apriamo quindi la prima immagine (canale R) attraverso il menù File → Apri… . Chiudete i file di eliminazione dei pixel caldi e fredde e lasciate aperta solo l’immagine calibrata. Premete CTRL+A al fine di visualizzare correttamente l’immagine (Figura 2).

Figura 2: Pronti per utilizzare DBE sul canale R?

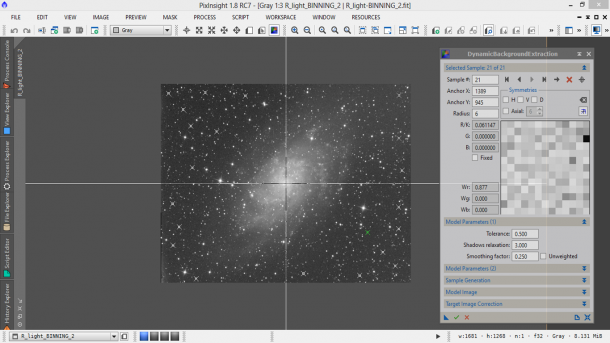

Clicchiamo quindi in vari punti dell’immagine evitando di selezionare parti del soggetto (nebulosità o alone galattico). Non sono necessari molti punti, l’importante è che abbiate una copertura (se possibile) di tutta l’immagine. Nel nostro esempio abbiamo selezionato 21 punti lontani dalla galassia (Figura 3).

Figura 3: Selezione dei punti utilizzati da DBE per uniformare il campo

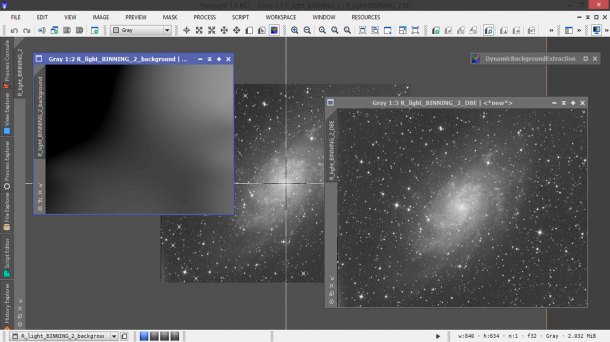

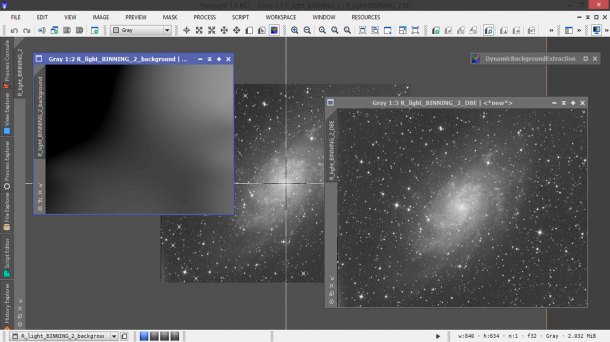

Lasciamo i parametri Model Parameters (1), Model Parameters (2), Sample Generation e Model Image invariati. Andiamo invece in Target Image Correction e selezioniamo Division in Correction se l’immagine non presenta gradienti dovuto all’inquinamento luminoso, Subctraction altrimenti. Lasciamo non spuntato il quadrato Normalize. Se i parametri settati sono corretti infatti il background ottenuto dal tool DBE dovrebbe essere neutro. Lasciamo deselezionato anche Discard background model al fine di ottenere una mappa della correzione applicata. Infine anche Replace target image deve rimanere non spuntata se vogliamo che le modifiche apportate vengano visualizzate in una nuova finestra. Lasciamo invariati i parametri dei campi Identifier e Sample format. Clicchiamo sulla spunta verde per eseguire il tool DBE. La nuova immagine e la relativa mappa saranno come al solito “nere”. Premete CTRL+A per avere una visualizzazione corretta (Figura 4).

Figura 4: l'applicazione del tool DBE.

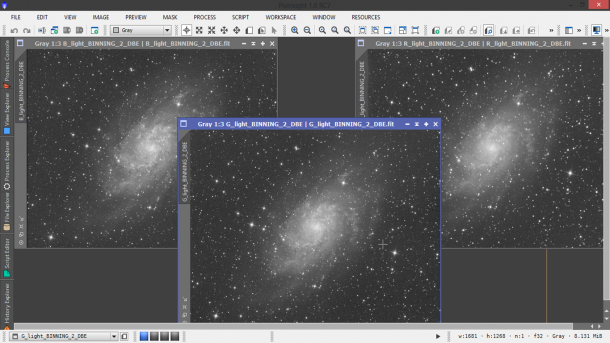

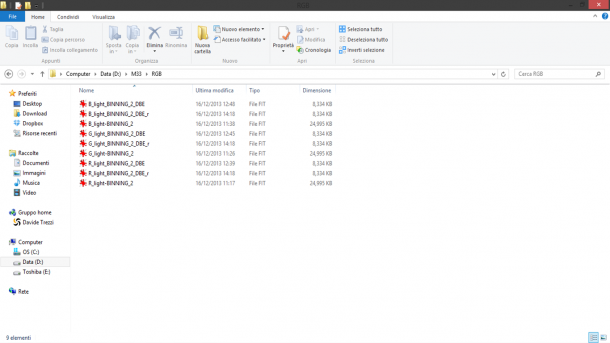

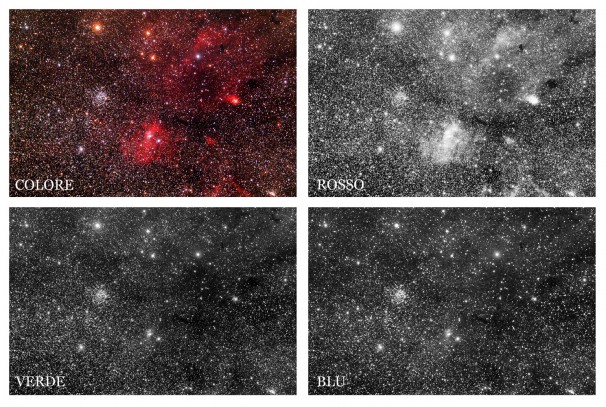

Salvate l’immagine “spianata” è disponibile tramite il menù File → Save As… . Applichiamo la stessa procedura anche per gli altri due canali (G e B). Al termine del processo avremo i tre canali con eventuali gradienti residui rimossi (Figura 5). A questo punto non ci resta che allineare i tre canali. Per far questo utilizzeremo il tool StarAlignment disponibile nel tab Process Explorer o dal menù Process → ImageRegistration → StarAlignment.

Figura 5: i tre canali pronti per l'allineamento e quindi la composizione RGB. Come si vede i gradienti residui sono stati praticamente eliminati dal tool DBE

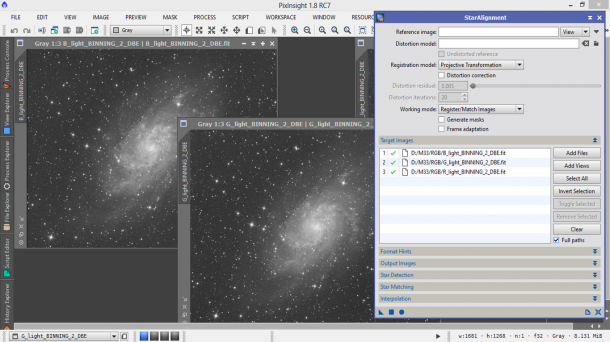

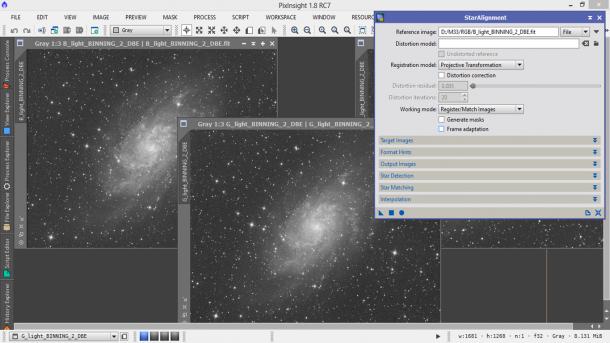

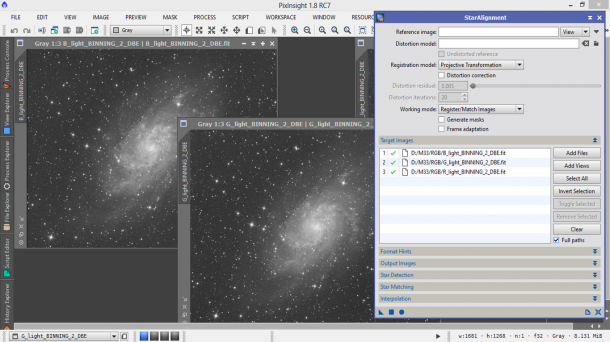

Una volta aperta la finestra del tool StarAlignment ci portiamo sulla sezione Target Images e aggiungiamo le immagini da allineare attraverso il pulsante Add Files. Una volta caricate le immagini relative ai tre canali, queste dovrebbero apparire con una spunta verde nel riquadro centrale come illustrato in Figura 6.

Figura 6: primo passo è caricare le immagini relative ai tre canali.

A questo punto nella sezione principale andiamo ad indicare File in Reference image e attraverso il triangolino laterale andiamo a selezionare il canale di riferimento. Prendiamo per esempio il canale blu (B). In generale questo canale dovrebbe essere quello con il soggetto meglio inquadrato e miglior rapporto segnale/rumore. Ovviamente, se i singoli frame sono stati acquisiti correttamente non dovrebbe esserci molta differenza tra i vari canali. Lasciamo in bianco il campo Disctorsion model dove è possibile inserire una matrice di distorsione. In Registration model indichiamo Projective Transformation, utile nel caso in cui le immagini da allineare sono simili. Se il telescopio non è soggetto a particolari aberrazioni lasciamo non spuntato il campo Distorsion correction. Come Working mode lasciamo quello di default ovvero Register/Match Images. Questo è il modo in cui le immagini vengono allineate. Ci sono varie opzioni a seconda che si stiano allineando immagini per una somma, composizione RGB/LRGB o realizzazione di un mosaico. L’opzione Generate masks va lasciata non spuntante, in quanto al momento non è richiesta la generazione di una mappa delle stelle messe a registro. Frame adaption invece può essere utile per ottenere immagini simili (come nei mosaici) ma in questo caso è consigliabile lasciarlo non spuntato (Figura 7).

Figura 7: impostazioni del tool StarAlignment.

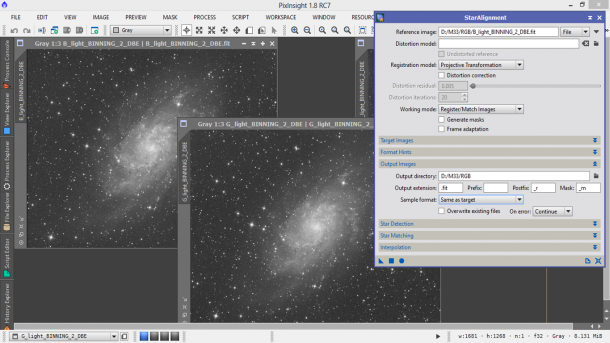

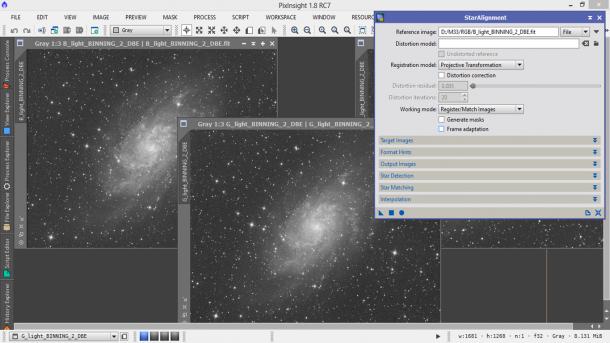

Andiamo quindi nella sezione Output Images, lasciando invariate le impostazioni di Format Hints e selezioniamo la cartella di output cliccando sul pulsante a forma di cartella. Il suffisso _r verrà aggiunto alle immagini allineate dal tool StarAlignment (Figura 8).

Figura 8: Determinazione della cartella di output del tool StarAlignment

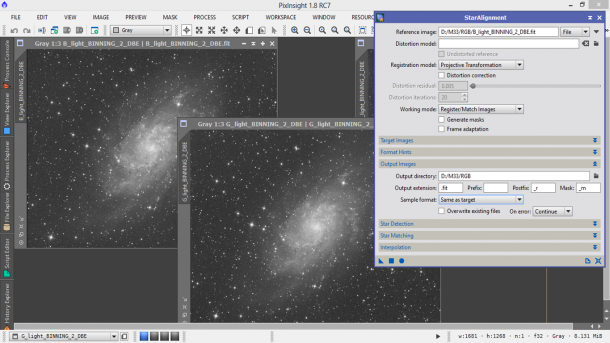

Quindi lasciando tutti gli altri parametri delle sezioni Star Detection, Star Matching e Interpolation invariati, clicchiamo sul pallino pieno in basso a sinistra per applicare il tool alle nostre immagini. A questo punto nella cartella di lavoro dovremmo avere le tre immagini (canali) originali, tre con suffisso _DBE relative alla riduzione dei gradienti e tre con suffisso _DBE_r ovvero le precedenti allineate rispetto al canale B (Figura 9).

Figura 9: le immagini corrette ed allineate pronte per essere sottoposte alla combinazione RGB.

COMPOSIZIONE RGB

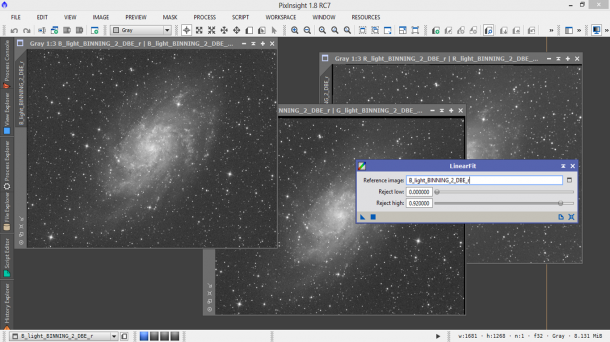

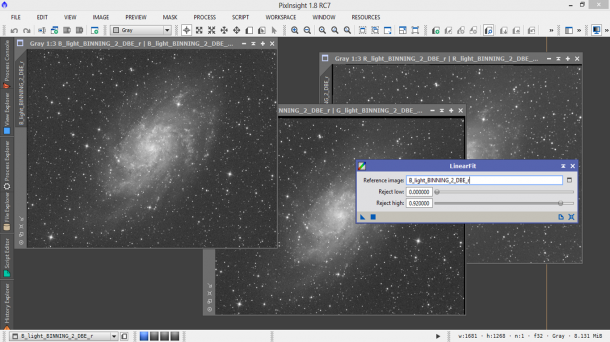

Sino ad ora ci siamo limitati a preparare le tre immagini relative ai canali rosso (R), verde (G) e blu (B). In questo paragrafo vedremo come comporli in una sola immagine a colori grazie al tool ChannelCombination. Ovviamente la parte di riduzione dei gradienti residui nei singoli canali può essere tralasciata nel caso le vostre immagini non presentino inquinamento luminoso o siano state corrette perfettamente attraverso i flat field frame. Prima di procedere dobbiamo però far si che tutti e tre i canali siano “confrontabili” in modo da non ottenere un’immagine a colori completamente sbilanciata. Per far questo cominciamo con l’aprire le immagini monocromatiche relative ai tre canali (allineate e con gradienti residui ridotti). Per far questo utilizziamo il menù File → Open… . Apriamo quindi il tool LinearFit o cercandolo nel tab Process Explorer o tramite il menù Process → ColorCalibration → LinearFit (Figura 10).

Figura 10: Il tool LinearFit per la calibrazione dei vari canali monocromatici.

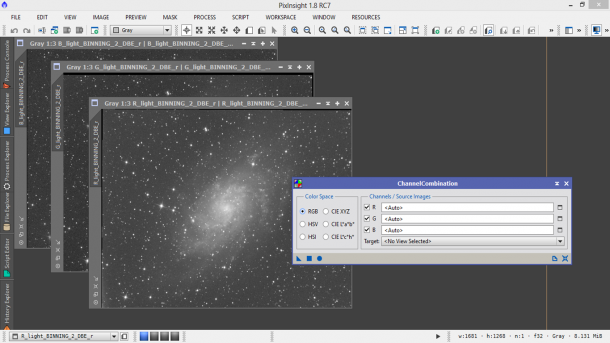

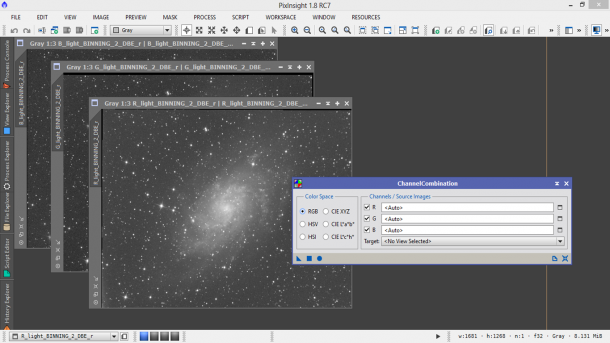

Nel campo Reference image andiamo a selezionare l’immagine relativa al canale di normalizzazione. In particolare nell’esempio considerato utilizzeremo il canale blu (B). A questo punto andremo a “normalizzare” le altre due immagini al blu trascinando il triangolino in basso a sinistra sulle due immagini relative ai canali R e G, dopodiché chiudiamo la finestra relativa a LinearFit. Non ci resta quindi ora che unire i tre canali al fine di ottenere l’immagine a colori RGB. Cerchiamo quindi il tool ChannelCombination nel nostro ProcessExplorer oppure cliccando sul menù Process → ChannelManagement → ChannelCombination (Figura 10).

Figura 11: Il tool ChannelCombination

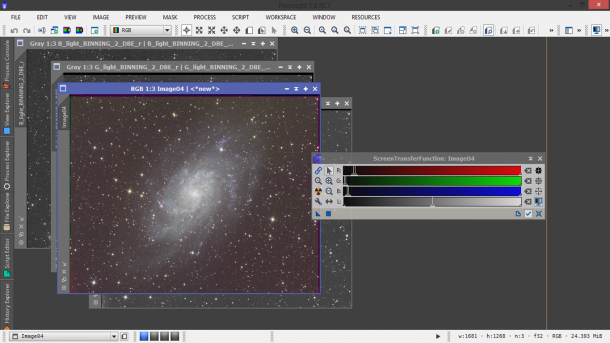

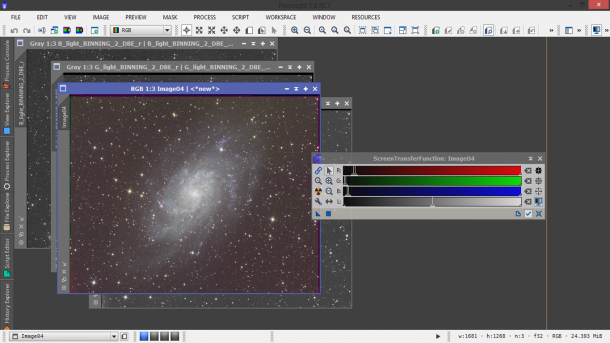

Cliccando sul simbolo a lato di ciascun canale andiamo a selezionare le nostre immagini allineate ed eventualmente corrette per gradenti residui e “normalizzate” con l’utility LinearFit, dopodiché clicchiamo sul pallino pieno in basso a sinistra. Il risultato ottenuto è un’immagine a colori (RGB) in prima approssimazione bilanciata correttamente (Figura 11). Per ottenere colori verosimili utilizziamo il tool ScreenTransferFunction disponibile sempre nel Process Explorer oppure dal menù Process → IntensityTransformation → ScreenTransferFunction. Selezioniamo l’icona con la catena (ovvero i tre canali sono vincolati) e premiamo sul simbolo “nucleare” ovvero AutoStretch. Dopo l’applicazione del tool l’immagine apparirà con i colori ben bilanciati (Figura 12).

Figura 12: l'immagine RGB prodotta a partire dai tre canali R,G e B.

Non ci resta quindi che salvare l’immagine RGB tramite il menù File → Save As… . Il piccolo gradiente rosso in basso a sinistra è dovuto alla formazione di ghiaccio sul CCD (eliminabile attraverso un crop dell’immagine).