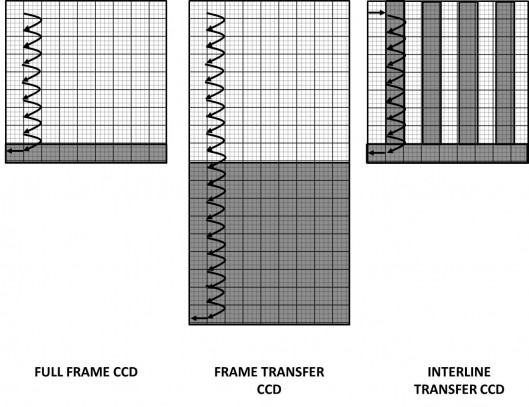

Formati dei sensori digitali

Negli scorsi articoli abbiamo studiato come, a partire dai fotoni cosmici, sia possibile ottenere sul monitor del nostro computer o in stampa bellissime immagini di corpi celesti. Alla luce di questo, possiamo concludere che il cuore dell’immagine fotografica moderna è il sensore. Questo è costituito da una griglia di elementi fotosensibili; quelli che poi saranno rappresentati (e spesso confusi) dai pixel nelle nostre immagini digitali. Esiste quindi una stretta relazione tra la forma del sensore e quella dell’immagine finale. E’ esperienza comune maneggiare stampe fotografiche dalle forme rettangolari e pertanto possiamo dedurre che questa corrisponda alla geometria del nostro sensore. Ma perché questa scelta? Il “rettangolo” fotografico ha delle proporzioni ben determinate? Quanti formati esistono? In questo articolo vedremo di dare una risposta a tutte queste domande.

QUESTIONE DI FORMA

La disposizione degli elementi fotosensibili non è dettata da nessun vincolo costruttivo e pertanto questi potrebbero essere disposti nelle forme più incredibili. Questo avviene in ambiti dedicati alla ricerca scientifica dove si usano spesso sensori dalle forme circolari, a bande o altro. In fotografia la forma più naturale dovrebbe essere il cerchio. Infatti il sensore deve raccogliere i fotoni che ci arrivano dal sistema ottico che ovviamente, essendo di forma cilindrica, produce sul piano focale un cerchio. Eppure avete mai visto stampe circolari? Ebbene in passato esistevano, come ad esempio la camera Kodak No.1 del 1888 produceva immagini circolari. Allora perché oggi utilizziamo pellicole rettangolari? La soluzione è di natura economica. La produzione di sensori circolari comporta un grosso spreco in termini di stampa dato che queste avvengono sempre su carta di formato quadrato o rettangolare.

Escludendo il cerchio, la forma più naturale per un sensore dovrebbe quindi essere il quadrato. Questa forma geometrica ha avuto ampio sviluppo in passato, mentre oggi sta diventando un formato sempre più di nicchia. Un esempio è il medio formato 6 x 6, di dimensioni 56 x 56 mm, utilizzato in passato dalla Yashica-D a partire dal 1958.

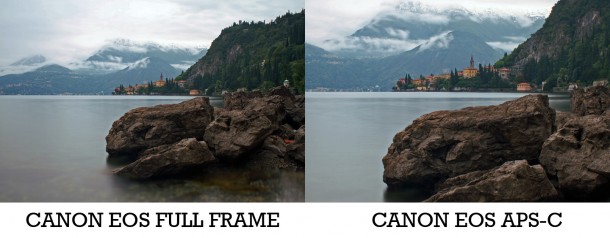

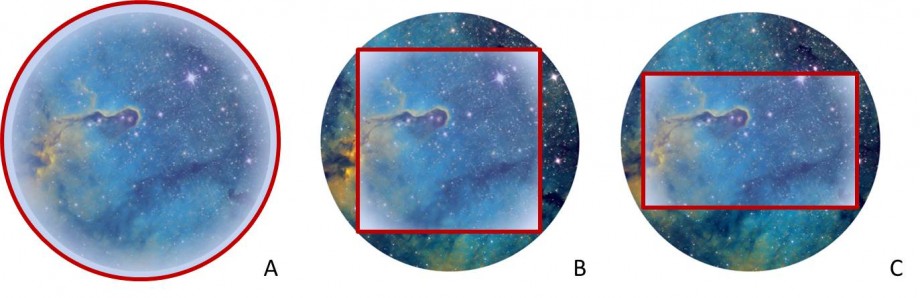

Oggi, la maggior parte dei sensori è rettangolare. L’utilizzo di questa forma geometrica ha origini storiche, psicologiche e pratiche. La fotografia ha seguito un’evoluzione parallela alla stampa che spesso utilizza carta rettangolare in rapporto DIN (ovvero rapporto tra i lati pari a 1.414). Questo fu il motivo storico per cui si preferì il formato rettangolare a quello quadrato. Tale fatto giustificherebbe il perché oggi i sensori rettangolari hanno rapporti spinti, simili a quelli presenti in schermi wide-screen o dei dispositivi mobili, oggetti tecnologici che hanno ormai sostituito la carta stampata. Un’altra giustificazione è di natura pratica e dovuta al fatto che un sensore rettangolare è meno sensibile ai difetti associati all’ottica dato che l’immagine finale è ottenuta da zone lontane dai bordi del campo dove si ha spesso la caduta di luminosità e della qualità dell’immagine (vignettatura e coma). Quindi l’utilizzo di sensori rettangolari richiede una qualità ottica inferiore e quindi un risparmio per le ditte produttrici (Figura 1).

Figura 1: La forma più naturale per un sensore è il cerchio (A) che purtroppo risulta non ottimizzata per la stampa. Il quadrato (B) è migliore ma, rispetto al rettangolo (C) è più soggetto alla presenza di difetti ottici. Inoltre il rettangolo è più adatto alla stampa commerciale oltre ad essere più "gradevole" da un punto di vista estetico.

Infine, a queste due motivazioni tecnologiche bisogna aggiungerne una di natura psicologica. Il rettangolo, specie se di proporzioni auree (ovvero rapporto tra i lati pari a 1.618), risulta assai più gradevole agli occhi di un quadrato. A seguito di tutti questi fattori, storicamente si optò per l’utilizzo di sensori di forma rettangolare. Ma con quale rapporto? Di che dimensioni?

LO ZOO DEL FORMATO

Essendo frutto di spinte differenti, il rapporto tra i lati del rettangolo che costituiscono il sensore così come le sue dimensioni sono praticamente casuali. Ad oggi esistono infinite combinazioni di lati e rapporti. Alcuni di questi, riportati in Tabella 1, si sono diffusi più di altri.

| Nome Formato | Base (mm) | Altezza (mm) | Rapporto |

| 1/2.5” | 5.76 | 4.29 | 1.343 (4:3) |

| 1/1.7” | 7.6 | 5.7 | 1.333 (4:3) |

| 2/3” (Fuji, Nokia) | 8.6 | 6.6 | 1.303 (4:3) |

| 1” (Nikon, Sony) | 13.2 | 8.8 | 1.5 (3:2) |

| Four Thirds System (Olympus, Panasonic) | 17.3 | 13 | 1.331 (4:3) |

| Foveon (Sigma) | 20.7 | 13.8 | 1.5 (3:2) |

| APS-C (Canon) | 22.2 | 14.8 | 1.5 (3:2) |

| APS-C (Nikon, Sony, Pentax, Fuji) | 23.6 | 15.7 | 1.503 (3:2) |

| APS-H (Canon) | 28.7 | 19 | 1.510 (3:2) |

| Full Frame (35 mm) | 36 | 24 | 1.5 (3:2) |

| ATIK 314L+ (Sony ICX-285AL) | 8.98 | 6.71 | 1.338 (4:3) |

| ATIK 383L+ (Kodak KAF 8300) | 17.6 | 13.52 | 1.302 (4:3) |

| ATIK 11000 (Kodak KAI 11002) | 37.25 | 25.70 | 1.449 (3:2) |

| Imaging Source DMK41 (Sony ICX-205AL) | 7.6 | 6.2 | 1.223 (5:4) |

| Celestron NexImage 5 | 5.7 | 4.28 | 1.332 (4:3) |

Tabella 1: Esempi di formati più diffusi.

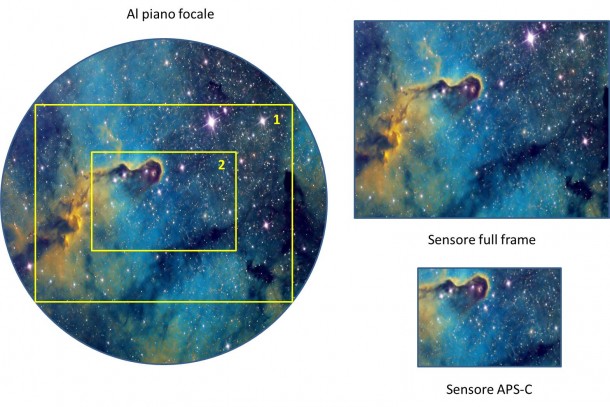

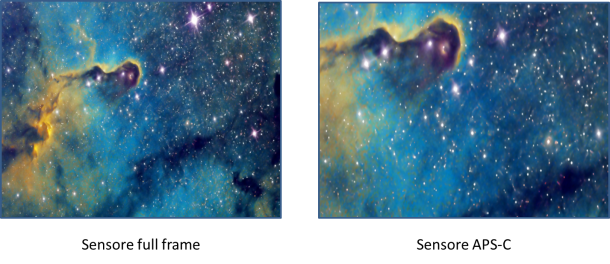

In particolare, in cinematografia si diffuse a partire dal 1909 il formato 35 mm. Questo aveva dei fori ai lati per il trascinamento della pellicola durante la proiezione video. Lo stesso formato venne convertito nel fotografico 135 che manteneva i fori ai lati ed una dimensione dei fotogrammi pari a 24 x 36 mm. Tale formato si diffuse e costituì lo standard per le pellicole fotografiche nelle fotocamere analogiche (vedi Figura 2). Con l’avvento della tecnologia digitale si cercò di ottenere fotocamere con sensori di dimensioni 24 x 36 mm, note come sensori full frame. Ad oggi, la maggior parte dei sensori digitali hanno dimensioni inferiori a 24 x 36 mm e pertanto si associa al termine full frame quello di pieno formato. Questa terminologia è interessante in quanto, nella fotografia analogica, il formato 24 x 36 mm era spesso ritenuto piccolo rispetto ai più grandi medio e grande formato.

Figura 2: il formato 135, il più diffuso nel mondo della fotografia analogica amatoriale e semi-professionale.

La stessa varietà di forme e rapporti presenti nell’ambito della fotografia tradizionale si riflette nella fotografia astronomica dove i formati più diffusi sono stati riportati in Tabella 1. Le dimensioni dei sensori così come quelle degli elementi fotosensibili che li costituiscono determinano anche il fattore crop e quindi il loro utilizzo. Ecco quindi che sensori molto piccoli e con un’elevata densità di pixel vengono utilizzati nelle riprese planetarie al fine di massimizzare l’ingrandimento ottenuto dall’ottica mentre grandi sensori con pixel molto grandi sono preferibili per la fotografia astronomica DeepSky dove invece è richiesta alta sensibilità alla debole luce proveniente da oggetti lontani oltre che ad un grande campo per riprenderli nella loro interezza. Per maggiori informazioni sull’effetto crop consigliamo la lettura dell’articolo “il fattore di crop“.