In questa recensione analizzeremo il rifrattore acromatico MEADE LXD75 EMC acquistato in data 24/01/2014 presso il negozio Miotti Ottica di Milano. Il telescopio, con un diametro di ben 152 mm ed una lunghezza focale di 1200 mm, si presenta ben imballato in uno scatolone di dimensioni ben superiori, al limite della trasportabilità in automobile. Il peso dello strumento si aggira intorno ai 13 kg, raggiungendo il valore 15.3 kg quando equipaggiato di anelli e piccolo telescopio di guida rifrattore SkyWatcher 70 mm f/7.1.

Figura 1: il rifrattore acromatico MEADE LXD75 EMC con anelli e telescopio di guida.

Aperta la scatola troviamo, oltre al tubo ottico un cercatore 8 x 50 mm, un diagonale del diametro da 31.8 mm ed un oculare Meade Plössl da 26 mm con diametro sempre da 31.8 mm. Una nota negativa va al cercatore 8 x 50 mm, che seppur di ottima qualità meccanica, presenta un sostegno Meade non universale e incompatibile con il classico incastro a coda di rondine standard. Se quindi un futuro vorrete cambiare cercatore, sarete obbligati a cambiare anche il sostegno dello stesso. L’oculare invece è di ottima qualità, un po’ meno il diagonale. Il tubo ottico, di colore bianco, si presenta robusto ed al suo interno sono presenti una serie di diaframmi. All’esterno una maniglia permette di muovere agevolmente il grande rifrattore una volta montato su montature di tipo equatoriale. Il focheggiatore, di colore nero, è a cremagliera con una vite superiore di serraggio. Le lenti da 152 mm di diametro sono alloggiate in una cella dotata di tre viti di collimazione. La prima sensazione è quella di trovarsi di fronte ad un telescopio imponente, forse più da osservatorio astronomico che da utilizzo amatoriale.

IN LABORATORIO

Passiamo quindi al primo test in laboratorio, effettuato il giorno 04/02/2014 con il prezioso supporto della ditta ARTESKY. Come prima cosa ci accorgiamo che la vite che fissa la slitta della cremagliera è allentata. Ovviamente il problema è facilmente superabile stringendola con un l’aiuto di un piccolo cacciavite. Sempre rimanendo in tema “messa a fuoco” ci rendiamo subito conto che questa risulta poco fluida, a scatti, e troppo rigida. Decidiamo quindi di allentare le quattro viti del focheggiatore rendendo il movimento del sistema più fluido, condizione fondamentale per ottenere una corretta messa a fuoco.

Figura 2: le quattro viti di regolazione del focheggiatore

Finito con il focheggiatore, testiamo la collimazione delle ottiche utilizzando un cannocchiale collimatore Takahashi. Ovviamente, come attendibile, le ottiche si sono mostrate completamente scollimate. Prendiamo quindi l’occasione per rimuovere l’ottica, pulirla, e sostituire le viti di collimazioni con delle brugole. Dopodiché abbiamo rimontato il sistema e collimato con precisione il rifrattore.

Figura 3: l'ottica del rifrattore smontata dalla sua cella.

SUL CAMPO

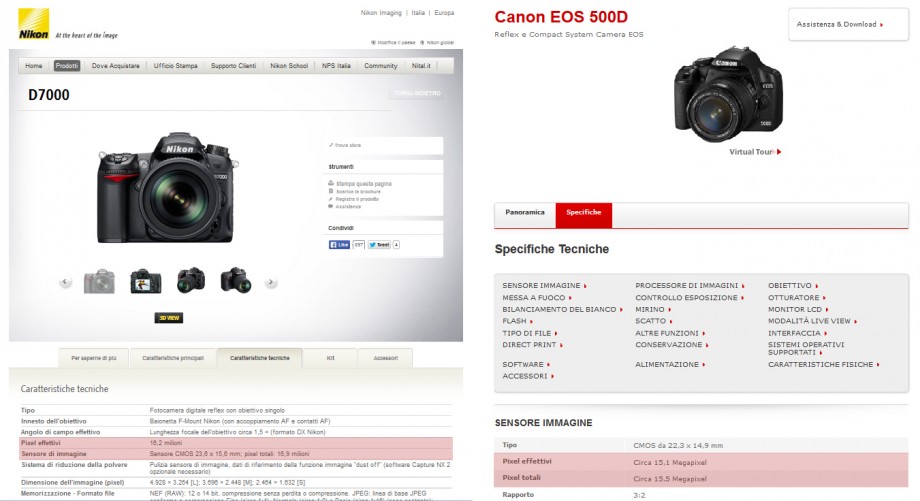

Il giorno 09/02/2014 decidiamo di effettuare la prima prova sul campo grazie anche alle condizioni di cielo sereno (uniche prima e dopo numerosi giorni di pioggia). Purtroppo l’instabilità atmosferica ed un leggero vento non garantiscono un buon seeing e pertanto non abbiamo potuto spingerci a molti ingrandimenti. Abbiamo effettuato alcuni test, al fine di determinare la qualità e le possibilità che questo strumento offre. Prima di analizzare le varie prove va detto che lo strumento è molto pesante e richiede l’utilizzo di montatura modello NEQ6, AZ-EQ6 o superiori. Purtroppo però la barra a coda di rondine Meade non entra nell’alloggiamento della montatura e quindi è necessaria sostituirla con una Vixen o Losmandy. Noi abbiamo optato per la seconda. Infine l’utilizzo di una classica montatura equatoriale alla tedesca comporta la presenza di molte zone morte del cielo (il tubo va a sbattere sulle gambe del treppiede) e pertanto consigliamo l’utilizzo di una colonna o di una mezza colonna.

LUNA

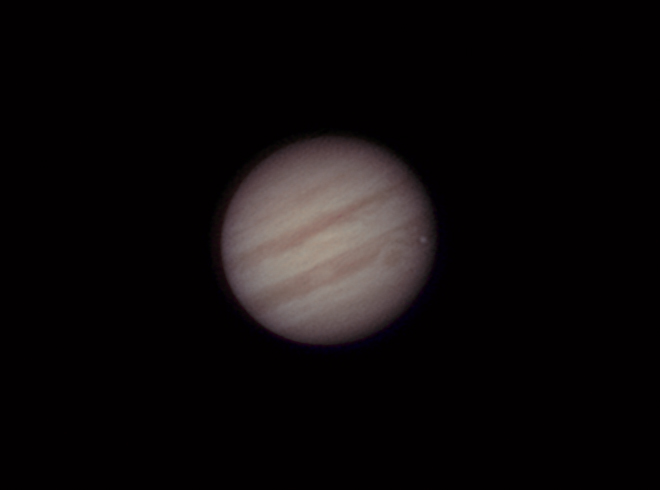

Dato che altre recensioni disponibili in rete affermano che il telescopio si comporta bene sul profondo cielo e nel caso di stelle poco luminoso, abbiamo deciso di testarlo su oggetti luminosissimi quali Luna e Giove. All’oculare la Luna appare veramente incisiva e malgrado la turbolenza, con una ricchezza di dettagli ben superiore a quella offerta da un riflettore Newton da 200 mm di diametro, di uguale fascia di prezzo. Non si percepisce nessuna aberrazione cromatica se non un debole alone giallo intorno al bordo lunare che però sparisce muovendo l’occhio nel campo inquadrato dall’oculare (Meade Plössl da 20 mm). Il cromatismo è praticamente nullo ad ingrandimenti elevati (300 x). Su Giove invece il cromatismo diviene evidente anche se è possibile con facilità scorgere tutti i dettagli superficiali. I satelliti galileiani appaiono stampati sul fondo del cielo e perfettamente puntiformi. La Luna, osservata in luce diurna, mostra un campo piano con poca vignettatura. In figura 4 è riportata un’immagine della Luna ripresa in luce diurna (per valutare la vignettatura) e notturna (per i dettagli superficiali). La camera di ripresa è una Canon EOS 700D.

Figura 4: Luna ripresa in luce diurna (sinistra) e notturna (destra). In quest'ultima è possibile vedere un marcato cromatismo ai bordi.

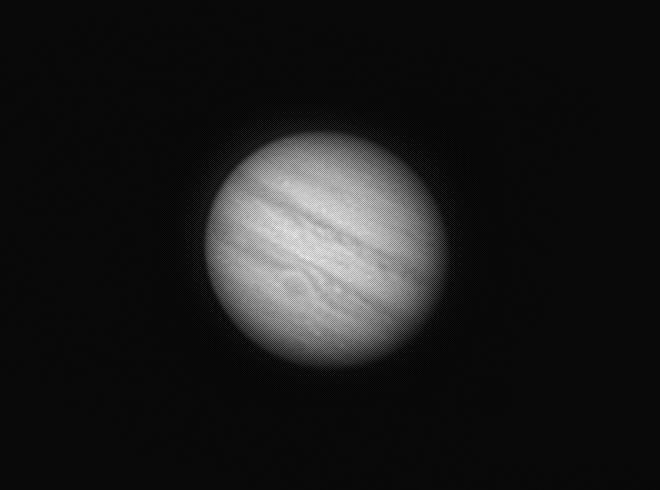

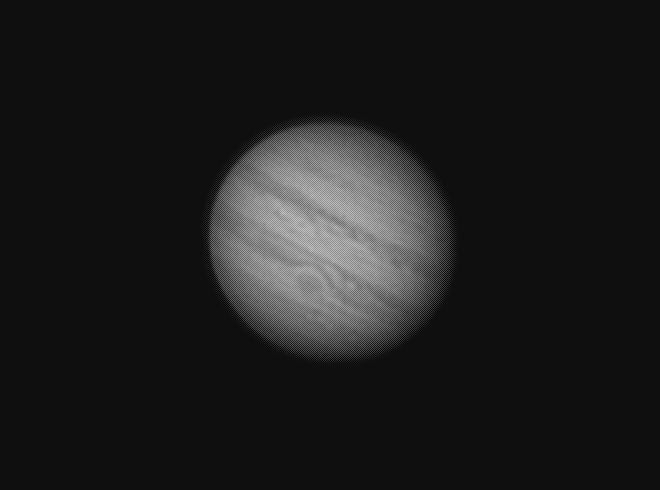

Abbiamo provato a riprendere anche due video di Luna e Giove con la camera di guida Magzero MZ-5m (monocromatica) come mostrato in figura 5. Ci scusiamo per la quantità di polvere presente sul sensore, ma come gli astrofotografi ben sanno, la camera di guida è in perenne battaglia con lo sporco 😉 .

Figura 5: Luna e Giove ripresi con la camera monocromatica di guida Magzero MZ-5m

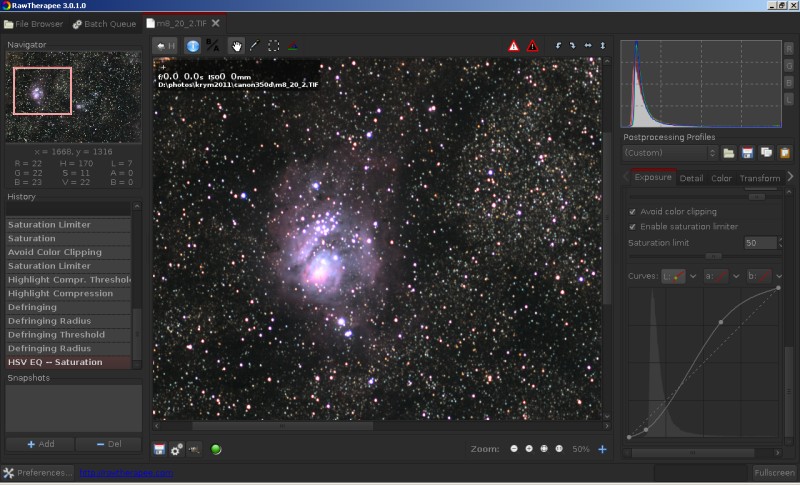

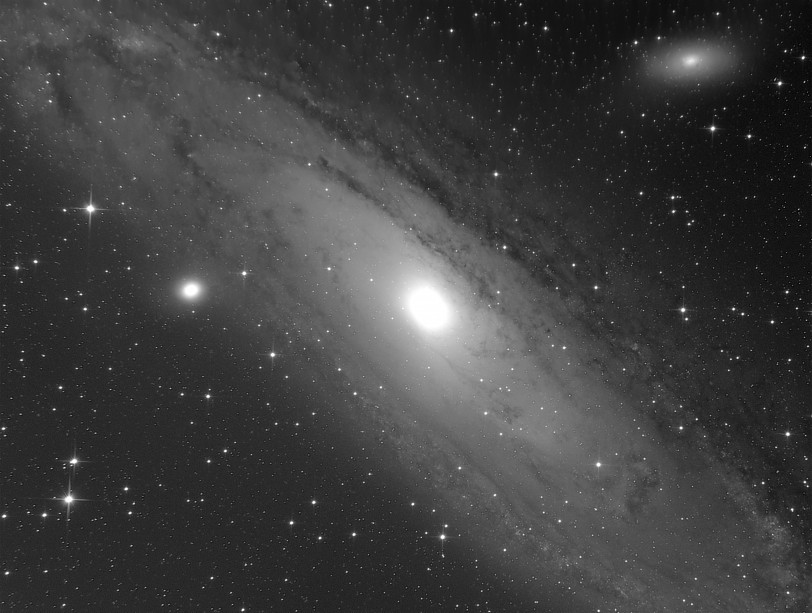

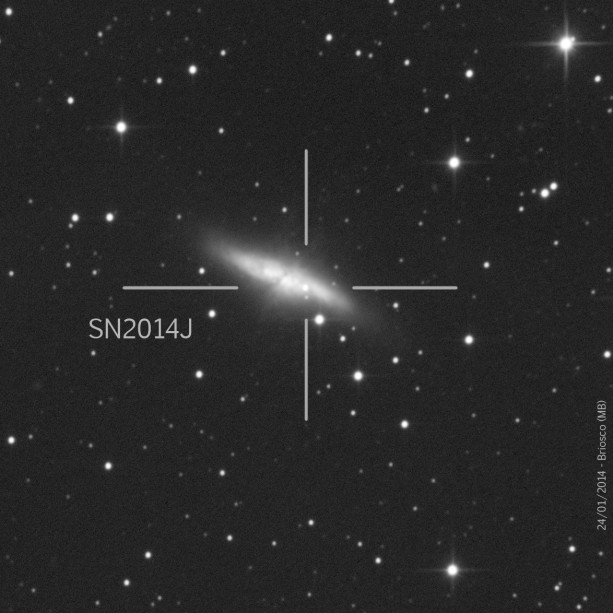

SUPERNOVA SN2014J IN M82

Dopo aver ripreso ed osservato Luna e Giove, siamo passati a riprendere un oggetto deepsky di attualità: la supernova SN2014J nella galassia M82 (Orsa Maggiore). Per fare ciò ci siamo avvalsi di una camera CCD ATIK 383L+ monocromatica dotata di filtro UHC-E per la riduzione dell’inquinamento luminoso e rosso R, entrambi della ditta Astronomik. L’utilizzo di un filtro colorato è d’obbligo al fine di selezionare un fuoco solo con relativa riduzione dei diametri stellari. Purtroppo ci siamo imbattuti subito in una problematica. La messa a fuoco ad occhio è molto difficile con questo tipo di rifrattore, data la qualità del focheggiatore. Diventa pertanto obbligatorio l’utilizzo di una maschera di Bahtinov. Con questa siamo riusciti ad ottenere una immagine a fuoco della galassia e della relativa supernova come riportato in figura 6. Il primo risultato sembra buono, ottenendo una M82 di discreta qualità.

Figura 6: la supernova SN2014J in M82.

AMMASSO APERTO M35

L’immagine della galassia M82 sembra mostrare stelle puntiformi. Ma siamo sicuri che questa condizione è verificata sino al bordo del campo della CCD? Per fare questo abbiamo fatto uno scatto, con il medesimo setup, all’ammasso aperto M35 nella costellazione dei Gemelli. Questo ammasso di grandi dimensioni occupa tutto il campo di ripresa. Il risultato è riportato in figura 7 e mostra stelle a bassa elliticità fino ai bordi, risultato impressionante considerando il fatto che non è stato utilizzato nessuno spianatore di campo.

Figura 7: l'ammasso aperto M35 nella costellazione dei Gemelli.

NEBULOSA DI ORIONE

Ma quando piccole sono effettivamente le stelle riprese da questo grande rifrattore? Per dare una valutazione qualitativa abbiamo provato a riprendere la nebulosa di Orione con CCD ATIK 383L+ con filtro Astronomik Hα da 13 nm. Il risultato è mostrato in figura 8. Malgrado il grande rapporto focale (f/8) dello strumento, il MEADE LXD75 EMC si è mostrato ottimo anche per le riprese in banda stretta (H alfa).

Figura 8: la nebulosa di Orione ripresa a banda stretta.

Per concludere, anche perché le condizioni meteo non ci hanno permesso di effettuare altri test, abbiamo provato a scattare una foto alla nebulosa di Orione con una Canon EOS 7D, per valutarne il cromatismo fotografico. L’immagine RGB, mostrata in figura 9 presenta aloni colorati e nell’insieme risulta piuttosto scarsa.

Figura 9: nebulosa di Orione ripresa con una Canon EOS 700D

CONCLUSIONI

Il MEADE LXD75 EMC in esame si è rivelato un ottimo rifrattore acromatico, a patto di effettuare un controllo di collimazione in laboratorio. Nel visuale è sbalorditivo anche se ci sarebbe piaciuto testarlo anche sul deepsky. Nel fotografico invece è necessario fare delle distinzioni. Con una reflex (non full frame) o CCD a colori, le immagini ottenute risultano si quasi prive di vignettatura ma colpite da forte aberrazione cromatica. Nel caso invece di CCD monocromatiche, il MEADE LXD75 EMC si comporta come un rifrattore corretto, direi apocromatico, a patto di variare la posizione del fuoco a seconda del filtro utilizzato. Ovviamente gli ingombri ed il peso dello strumento lo rendono poco trasportabile. Consigliamo inoltre di esporre il telescopio alla temperatura ambiente per una trentina di minuti al fine di acclimatare le ottiche. Un possibile aggiornamento, consigliato nel caso in cui questo sia il telescopio principale o definitivo, è la sostituzione del corpo focheggiatore. Inoltre facciamo notare che, se si montano dei filtri sul naso da 2 pollici di una CCD o reflex, questo non va più in battuta nel focheggiatore a causa della presenza del dado di fissaggio della rotaia a cremagliera.