L’astrofotografia di tutti i giorni

Quando si osservano immagini di galassie o ammassi stellari ripresi da osservatori astronomici o astrofotografi professionisti si rimane spesso a bocca aperta pensando che quel mondo sia anni luce da quello che possiamo “raggiungere” noi comuni mortali con le nostre fotocamere digitali. In parte è vero in quanto per fare delle riprese in dettaglio di oggetti astronomici sono necessarie strumentazioni sofisticate e molto spesso costose ma non dobbiamo abbandonare le nostre speranze. Infatti è possibile essere astrofotografi anche con della semplice strumentazione economica. Vediamo in questo post cosa può fare un neofita di astrofotografia con la propria strumentazione.

TRAMONTI ED ALBE

Astronomia non è solo cielo stellato. Albe e tramonti sono gli oggetti più semplici da riprendere, data la richiesta minima di strumentazione, e danno la possibilità all’astrofotografo di esprimere tutta la sua personalità. Quando guardate le immagini di un ammasso di stelle, una galassia o una nebulosa cosa vi comunica l’autore? Nulla. Potete dire che una ripresa è più bella perché mostra maggiori dettagli o perché si è usata una focale corretta ma della personalità dell’autore praticamente non c’è traccia. Nel caso di tramonti e albe invece il discorso è completamente opposto. La tecnica è banale.

Prendete la vostra macchina fotografica (sia essa una compatta o una reflex), inquadrate il Sole al tramonto (alba) o le luci del crepuscolo e scattate. Il gioco è fatto! Quali suggerimenti possiamo dare a questi tipi di astrofotografi?

- Se riprendete con il settaggio della vostra fotocamera “automatico” (questo è sempre vero per le compatte), allora puntate il cielo, premete il tasto di scatto finché la camera non mette a fuoco; dopodiché sempre con il tasto premuto abbassate lo sguardo riprendendo anche l’orizzonte. In questo caso la fotografia rimarrà leggermente sottoesposta garantendo un bel colore del cielo a scapito di un orizzonte nero (silhouette). Potete anche fare il contrario mettendo a fuoco l’orizzonte e alzando poi la camera. In questo caso il cielo sarà sovraesposto dando un coloro azzurrino chiaro e colori smorti, mentre il paesaggio sarà correttamente esposto.

- Se riprendete con il settaggio della vostra fotocamera “manuale” allora potete giocare con i tempi di esposizione e se necessario applicare la tecnica HDR. Se il Sole è ancora presente e molto luminoso, allora chiudete il diaframma dando luogo all’effetto stella.

- Dopo alcuni minuti dal tramonto (o alcuni minuti prima dell’alba) le luci del crepuscolo si fanno sempre più deboli (intense) cedendo il passo alla notte (giorno). Se volete comunque riprendere il colore blu del cielo allora munitevi di cavalletto e se avete una compatta impostate l’autoscatto (in modo da evitare il mosso) se invece avete una reflex utilizzate un telecomandino per lo scatto remoto… quello che una volta si chiama flessibile.

- Il cavalletto, utile per le riprese a tramonto (alba) avanzato (anticipata) non deve essere necessariamente di alta qualità. Basta anche un prodotto scadente da supermercato.

- Ricordatevi che le luci del tramonto danno un colore rosato al paesaggio mentre l’alba è spesso di colore azzurro-verde.

- Riprendete il tramonto (o l’alba) dallo stesso luogo in periodi dell’anno differenti (ad esempio in prossimità di solstizi ed equinozi) e vedrete il movimento del punto di tramonto (alba) durante l’anno. E chi ha detto che il Sole sorge sempre ad est e tramonta ad ovest? 🙂

Ovviamente ambientate il vostro tramonto (alba)! Se mettete un soggetto in primo piano ricordatevi (oltre alla regola dei terzi) di dare un colpo di flash o di illuminarlo con luce artificiale dato che altrimenti ne otterrete solo la silhouette. Per i più esperti: utilizzate ISO bassi e diaframmi chiusi al fine di ottenere la massima profondità di campo… in questo caso ovviamente dovrete utilizzare il cavalletto. Non vi resta che dare luogo alla vostra fantasia!!!

INQUINAMENTO LUMINOSO E FENOMENI ATMOSFERICI

L’inquinamento luminoso è una di quelle parole che fanno rabbrividire qualsiasi astrofotografo (che non usa filtri interferenziali). Eppure per il neofita può essere spunto per realizzare i primi lavori “notturni”. Infatti montate la vostra fotocamera digitale (compatta o reflex) su un cavalletto (anche economico) e impostate la posa autoscatto. Puntate un paesaggio cittadino visto da un punto panoramico e scattate.

La Brianza, di notte, offre il peggio di se trasformandosi in una fornace ardente di luci le quali, invece di illuminare le strade, gettano i loro raggi verso il cielo impedendoci la visione dell'Universo.

Il risultato ottenuto sarà davvero spettacolare! Alcuni suggerimenti:

- Per chi ha una reflex valgono le regole del tramonto. Quindi dotatevi di telecomando per controllo remoto, chiudete il diaframma e utilizzate ISO bassi.

- Usate lampioni o luci parassite per illuminare un soggetto da anteporre al paesaggio “inquinato” oppure

- Lasciate al buio il soggetto al fine di creare l’effetto silhouette.

Quindi sfogate pure la vostra fantasia, magari mettendo la vostra silhouette o quella del vostro telescopio in primo piano.

Un altro nemico dell’astrofotografo sono le nubi. Sfruttatele comunque al meglio e in maniera analoga alle riprese dell’inquinamento luminoso riprendete nubi e velature (illuminate dalle luci cittadini), fulmini e temporali o aloni lunari. Un suggerimento? Prima di tutto portatevi l’ombrello!!! Non si sa mai. Secondo i più esperti (dotati di reflex) possono decidere se alzare gli ISO e aprire il diaframma al fine di avere nubi ferme oppure abbassare ISO e chiudere il diaframma per avere l’effetto mosso. Come nel paragrafo precedente: date sfogo alla vostra fantasia!!!

I PIANETI

Cosa sono i pianeti visti ad occhio nudo? Degli enormi stelloni!!! Quindi perché non riprenderli con le nostre fotocamere digitali (compatte o reflex)? Per i detentori di compatte la vita comincia a farsi difficile e la tecnica è quella dell’inquinamento luminoso… finché possibile. Infatti se Venere e Giove saranno di facile ripresa, per gli altri pianeti iniziano i problemi.

Venere (qui dall'isola di Madeira) è un valore aggiunto all'immagine di un fantastico tramonto. Giocate con i pianeti e ambientateli il più possibile in paesaggi indimenticabili!

Per i fotografi più esperti dotati di reflex allora il gioco si fa semplice potendo esporre ipoteticamente fino all’infinito grazie al telecomandino per il controllo remoto. Alcuni suggerimenti:

Ricordatevi di regolare ISO e diaframmi in modo che il pianeta (o lo stellone) non risulti mosso. Il cielo si muove durante la notte ed il fenomeno sarà molto più evidente a mano a mano che aumentare la lunghezza focale.

I pianeti a volte si trovano vicini (si parla di congiunzione). Non perdetevi queste occasioni per riprendere più pianeti, magari ambientati con chiese gotiche, statue o strane silhouette. Liberate pure la vostra fantasia.

- Ricordatevi sempre di ambientare la ripresa. La foto di un pianeta con un obiettivo (persino con un 1200 mm) non ha senso. Sono necessari parecchi metri di focale per ottenere qualche dettaglio interessante.

- Scattate una foto del pianeta dalla stessa posizione ogni giorno e sovrapponete le pose. Vedrete il movimento del pianeta con il passare dei giorni.

- I pianeti possono andare in congiunzione anche con la Luna… non perdetevi questi momenti per realizzare dei quadretti indimenticabili.

- I pianeti non si muovo, rispetto alle stelle fisse, con la stessa velocità della Luna. Può capitare quindi che in una stessa notte la Luna passi davanti ad un pianeta (si parla di occultazione). Non perdetevi queste opportunità per riprendere, magari con una posa ogni 5 minuti, l’intero transito.

Buon lavoro quindi e se volete sapere quando un pianeta è visibile da una determinata zona della Terra, utilizzate il software gratuito stellarium (vedi ASTROlink) o chiede ad un vostro amico o ad un gruppo di astrofili.

SOLE E LUNA

Ogni fotografo (anche professionista) che vuole iniziare il percorso dell’astrofotografia commette il solito errore: fotografare la Luna. Purtroppo, il fatto che il nostro cervello tende a far diventare più grandi gli oggetti bassi sull’orizzonte ci spinge a pensare che la Luna sia un oggetto grande e quindi facilmente fotografabile con una reflex o addirittura con una compatta. Purtroppo la Luna è piccola e se non avete un obiettivo con almeno 400-500 mm di focale abbandonate ogni speranza di riprende il nostro satellite naturale.

Non possiamo quindi fare nulla? Ovviamente no. E’ sempre possibile riprendere la Luna ambientata in un paesaggio seguendo le stesse regole del pianeta. Subito però si pone un problema. Se esponete correttamente un paesaggio o un soggetto la Luna apparirà sovraesposta (bianca). Purtroppo non ne potete uscire se non utilizzando la doppia esposizione o l’HDR. Di notte, per esporre correttamente un paesaggio avete bisogno di alcuni secondi di posa mentre per la luna bastano frazioni di secondi.

Se avete un obiettivo con focale pari a 400-500 mm allora mettete l’ottica su cavalletto (questa volta stabile, non economico) e grazie al telecomando remoto scattate. A seconda di ISO e diaframmi scegliete il corretto tempo di esposizione.

L'indimenticabile eclisse totale di Sole dell'11 Agosto 1999, ripresa in questo caso da Dachau a 420 mm di focale (full frame).

Le stesse argomentazioni utilizzate per la Luna valgono anche per il Sole. In questo caso ricordatevi di porre di fronte all’obiettivo un apposito filtro solare (chiedete ad un gruppo di astrofili) altrimenti rischiate di perdere la vista guardando nel mirino o il sensore o peggior cosa entrambi.

Un’altra ripresa interessante è l’analemma che si ottiene fotografando (con un grandangolo e senza filtri… suggerisco di non guardare nel mirino della reflex) la posizione del Sole nel cielo, vicino al punto di tramonto o alba nella stessa ora in vari periodi dell’anno. Il risultato finale è quello di un grosso 8 disegnato sul paesaggio scelto per l’ambientazione. Cercate foto dell’analemma su internet: sono veramente uno spettacolo!

Sempre con focali superiori a 400 mm potete riprende il Sole durante un’eclissi totale (senza filtro nel momento della totalità) o parziale (con filtro). Molto bello è riprendere il primo raggio di luce abbagliante dopo una totalità. Lo stesso può essere fatto per l’eclissi totali (e parziali) di Luna. Purtroppo in questo caso i tempi di posa superano il secondo e se non avete obiettivi luminosi o ISO sufficientemente elevati non riuscirete a riprendere la “Luna rossa” a meno di avere la presenza di mosso.

Interessante è la ripresa della Luna quando manca poco o quando è passata da poco la totalità. In questo caso se fate una lunga esposizione (nei limiti del mosso) potete vedere la parte “scura” (ombra) della Luna, mentre con le corte esposizione vedrete la parte “chiara” (penombra). Le due possono poi essere combinate con la tecnica della doppia esposizione o HDR.

È possibile infine anche giocare con la Luna come ha fatto il signor Lauren Laveder anteponendo al nostro satellite naturale un soggetto “bizzarro”.

LE COSTELLAZIONI E LA VIA LATTEA

Passiamo ora alla parte difficile, dove purtroppo gli amici delle fotocamere compatte devono abbandonarci. Si cominciano a riprendere le stelle! Ecco alcuni consigli per gli utilizzatori di reflex:

- Messa a fuoco: partiamo dalla cosa più semplice! Come mettere a fuoco le stelle? Stando all’infinito basta mettere l’obbiettivo sul simbolo ∞. Errore mai più grave. Per motivi di produzione, il simbolo ∞ posto sugli obiettivi NON corrisponde alla messa a fuoco per punti posti all’infinito. È necessario correggere la messa a fuoco spostandosi di poco da questo punto. Si può osservare la stella (ma va bene anche un lampione molto lontano) nel mirino della reflex o farsi aiutare con la funzione liveview oggi diffusa su quasi tutte le fotocamere digitali.

- Diaframma: la logica suggerirebbe chiuso per avere maggiore profondità di campo. Purtroppo la luce delle stelle è poca e come vedremo poi voi non potete esporre per lunghi tempi e quindi… aprite il più possibile.

- ISO: anche in questo caso la logica direbbe ISO bassi… però per gli stessi motivi illustrati nel punto precedente abbiamo bisogno di luce e quindi su con gli ISO!

- Focale: fisheye o grandangoli. Scordatevi di fare foto al cielo con focali superiori ai 50 mm. Per capire il perché passate al prossimo punto.

- Tempi di esposizione: dovete regolarvi voi. La sfera celeste ruota e quindi le stelle durante la notte si muovono. Questo produce un effetto mosso sulle vostre pose. Tale effetto sarà maggiore aumentando la focale e/o il tempo di posa. Focali piccole e tempi di posa corti sono l’ideale per avere delle immagini stellari ferme. In ogni caso (indipendentemente dal tempo di esposizione) vi serve un cavalletto stabile e il telecomando per il controllo remoto.

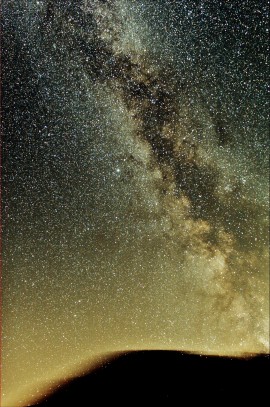

- Riprendere la Via Lattea? È possibile, almeno quella estiva… le regole sono quelle riportate precedentemente. Dato che la Via Lattea “cade” sull’orizzonte, potete ambientarla mettendo soggetti illuminati (o no per avere l’effetto silhouette) di fronte oppure farla cadere sul mare, monti o laghi. Per avere Via Lattea e paesaggio correttamente esposti si consiglia la tecnica HDR o della doppia esposizione.

- Se volete avere l’effetto stella sulle stelle più luminose, non potendo chiudere il diaframma potete utilizzare la tecnica del cavo. Prendete una corda molto spessa e formate una croce di fronte al vostro obiettivo fotografico. Riprendete in queste condizioni e vedrete come magicamente i puntini luminosi diventano stelle!

La costellazione di Orione fa capolino dietro l'osservatorio di Sormano, tra velature nuvolose illuminate dall'inquinamento luminoso.

Costellazioni e Via Lattea possono essere o meno ambientate. Decidete voi che taglio dare alla vostra fotografia utilizzando al meglio la vostra fantasia.

LA ROTAZIONE CELESTE

Avete imparato a riprendere stelle e costellazioni? Dimenticatevi tutto quello che avete letto in precedenza. Chiudete il diaframma a piacere, abbassate gli ISO (comunque non sotto i 200-400) ed esponete a piacere fino a qualche minuto di posa. Le stelle daranno il famoso “mosso”? E chi se ne frega! Non muovete la fotocamera e continuate a scattare. Alla fine della nottata otterrete tanti trattini sconnessi. Dateli in pasto al programma StraTrails e come per magia si trasformeranno in rotazioni celesti! Se poi puntate la stella polare vedrete come le strisciate (trail) diventeranno dei perfetti cerchi.

Suggerimenti:

- Non fate passare molto tempo tra una posa e l’altra, questo lascerebbe degli spazi neri tra le strisciate.

- Utilizzate un battery grip se possibile al fine svincolarvi dalle batterie (altrimenti saranno loro a decidere quando finirete la rotazione!).

- Sommate anche le foto con aerei o satelliti. Potrete sempre toglierli in post produzione con Photoshop!

Anche la rotazione ha bisogno di un’ambientazione e quindi via con la fantasia!!! Per maggiori informazioni si legga l’articolo “La tecnica dello star trail“.

TIME-LAPSE ASTRONOMICI

I Time-lapse sono semplicemente sequenze di immagini montate al fine di creare un video. Se le immagini sono riprese separate da intervalli di tempo superiori a 1/20 secondo allora l’effetto globale è quello di far scorrere il tempo più velocemente. In questo modo potete accelerare il tempo di tramonto o alba o il moto della sfera celeste.

LE COMETE

Anche per le comete valgono le leggi delle stelle. Se una cometa è molto luminosa (raggiungendo una luminosità confrontabile con quella dei pianeti) è possibile ambientarla con un paesaggio al fine di ottenere una bella immagine “natalizia”.

DISEGNARE CON LA LUCE

Avete mai pensato di disegnare con la luce? Quando il tempo di esposizione supera la decina di secondi allora è possibile utilizzare una torcia (meglio se con luce colorata e focalizzata) per disegnare. Questa tecnica, divenuta famosa con Picasso, permette di dar sfogo alla vostra fantasia disegnando cuori, stradine immaginarie o personaggi sul fondo di un paesaggio notturno, magari persino stellato. Ricordatevi che la luce è il vostro inchiostro e quindi spegnete la luce quando non volete disegnare!

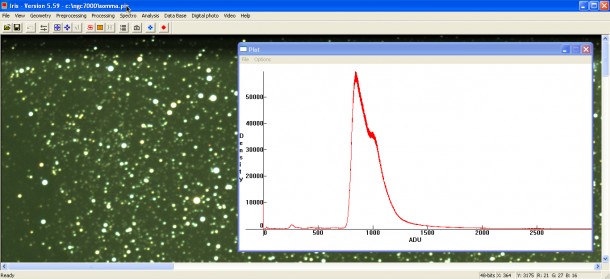

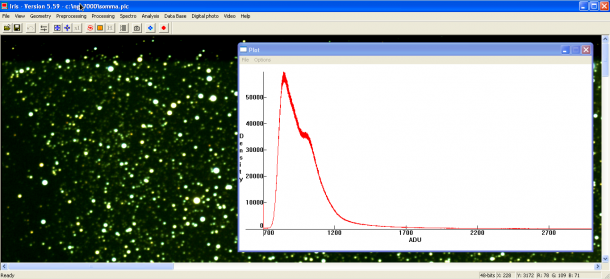

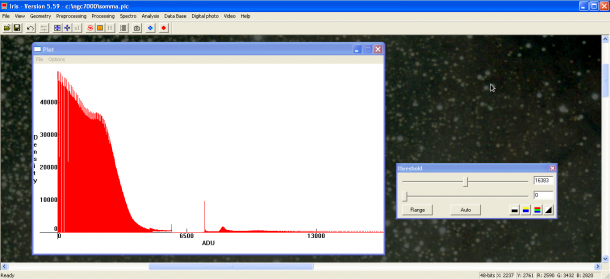

IL MONDO DEEP SKY

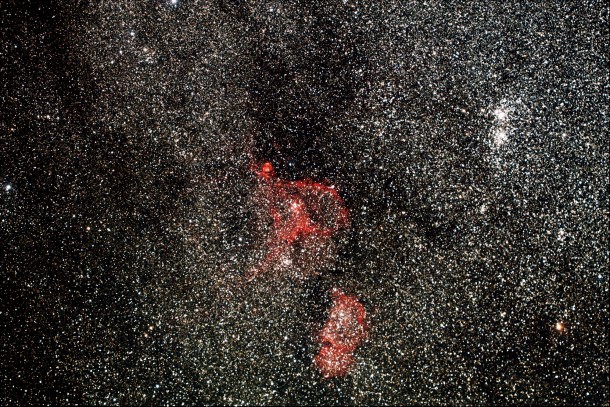

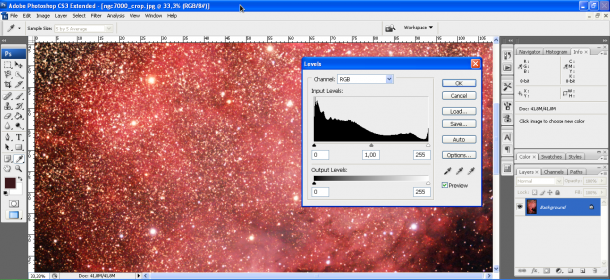

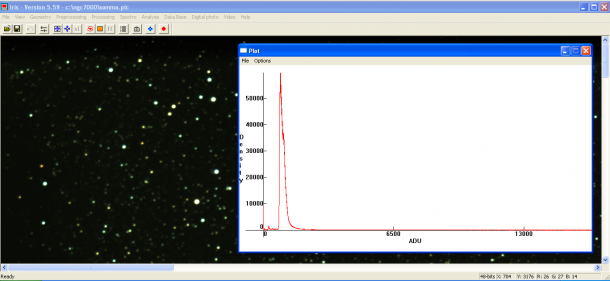

E cosa dire di nebulose, galassie ed ammassi di stelle? Poco. Purtroppo per riprendere le nebulose (tranne M42) è necessario modificare la fotocamera digitale sostituendo il filtro originale taglia infrarosso con uno a banda più larga. Per le galassie invece è la lunghezza focale a dominare e (tranne M31) sono necessari almeno 800 mm di focale per ottenere qualche dettaglio. Gli ammassi di stelle, così come M42 ed M31 possono essere riprese con la tecnica illustrata nel paragrafo “Le costellazioni e la Via Lattea”.

Come avrete letto non serve una strumentazione molto costosa per muovere i primi passi nel mondo dell’astrofotografia. Molto di quanto scritto lo si impara direttamente sul campo spesso sperimentando anche nuove tecniche, magari “rubati” da ambiti fotografici completamente differenti da quello astronomico. Pensiamo ad esempio alle tecniche Time-lapse e HDR appena entrate nel mondo dell’astrofotografia.

Una volta che avrete sperimentato queste prime tecniche astrofografiche illustrate in questo articolo potrete fare il prossimo step aumentando la vostra focale fino a 300 mm. Per far questo serve una montatura equatoriale motorizzata del costo approssimativo pari a circa 500 euro (anno 2012). Come vedete non ho parlato di telescopi. I telescopi sono due step più avanti… ma diamo tempo al tempo!