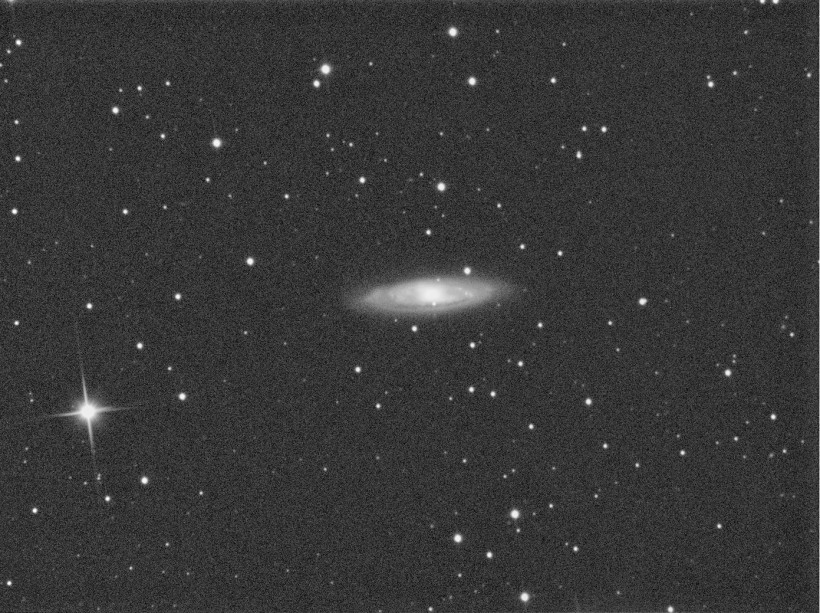

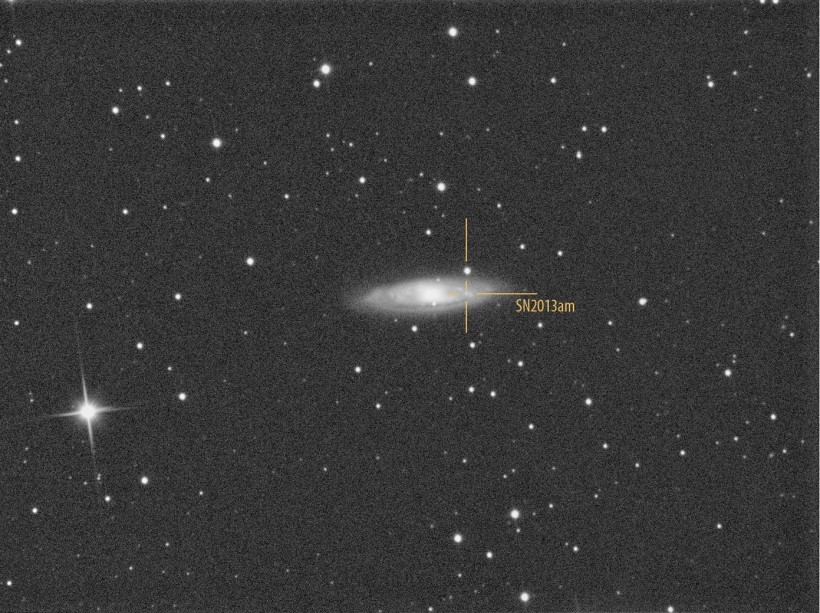

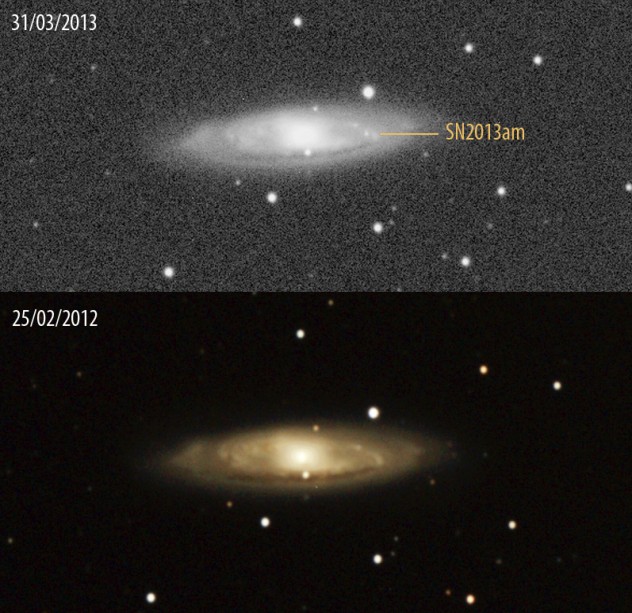

SN2013am – 31/03/2013

Telescopio o obiettivo di acquisizione (Imaging telescope or lens): Newton SkyWatcher BlackDiamond 150 mm f/5

Camera di acquisizione (Imaging camera): CCD Atik 314L+ B/W [6.45 μm]

Montatura (Mount): SkyWatcher NEQ6

Telescopio o obiettivo di guida (Guiding telescope or lens): Rifrattore ED (ED reftactor) Tecnosky Carbon Fiber 80mm f/7

Camera di guida (Guiding camera): Magzero MZ-5m B/W [5.2 μm]

Riduttore di focale (Focal reducer): non presente (not present)

Software (Software): IRIS + Adobe Photoshop CS3/CS6

Accessori (Accessories): correttore di coma Baader MPCC (coma corrector)

Filtri (Filter): Astronomik CCD L

Risoluzione (Resolution): 1391 x 1039 (originale/original), 1391 x 1039 (finale/final)

Data (Date): 31/03/2013

Luogo (Location): Sormano – CO, Italia (Italy)

Pose (Frames): 1 x 600 sec bin 1×1 a/at -10.0°C.

Calibrazione (Calibration): non presente (not present)

Fase lunare media (Average Moon phase): 74.7%

Campionamento (Pixel scale): 1.7616 arcsec/pixel

Focale equivalente (Equivalent focal lenght): 750 mm

Note (note): Riportiamo l’immagine in BW originale, di seguito la stessa con indicata la posizione della SN2013am e infine il confronto tra la galassia M65 ripresa il 31/03/2013 e quella del 25/02/2012 dove la supernova non era presente. // we post the picture of the SN2013am in BW original, with the supernova’s position indicated and a comparison between the image taken the 31st of March 2013 and the 25th of February 2013 where the supernova was not present.

Per scaricare i file originali in formato FIT clicca qui (password richiesta) / Click here in order to download the original files in FIT format (password request)